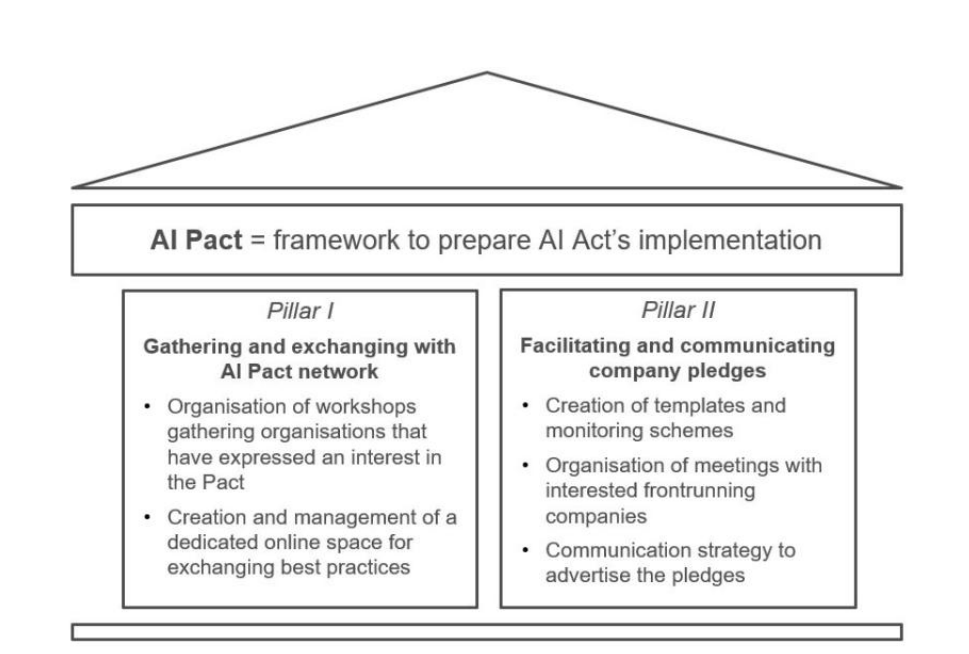

La Commissione UE ha pubblicato la bozza dell’AI Pact, Patto per l’IA, previsto dal Regolamento UE 2024/1689. Si tratta di un impegno volontario in base al quale i soggetti interessati (sviluppatori, fornitori, utilizzatori/deployers di sistemi IA) accettano di applicare fin da subito i requisiti previsti dall’AI Act della UE anche prima che la normativa entri pienamente in vigore.

Si ricorda che l’AI Act entrerà pienamente in vigore non prima del 2026.

Già 550 aderenti al patto per l’AI

Per ora hanno già aderito oltre 550 organizzazioni, tra sviluppatori e deployers di sistemi AI.

Dell’AI Pact aveva già parlato nei mesi scorsi Brando Benifei, Capo delegazione PD al Parlamento Europeo e correlatore dell’AI Act.

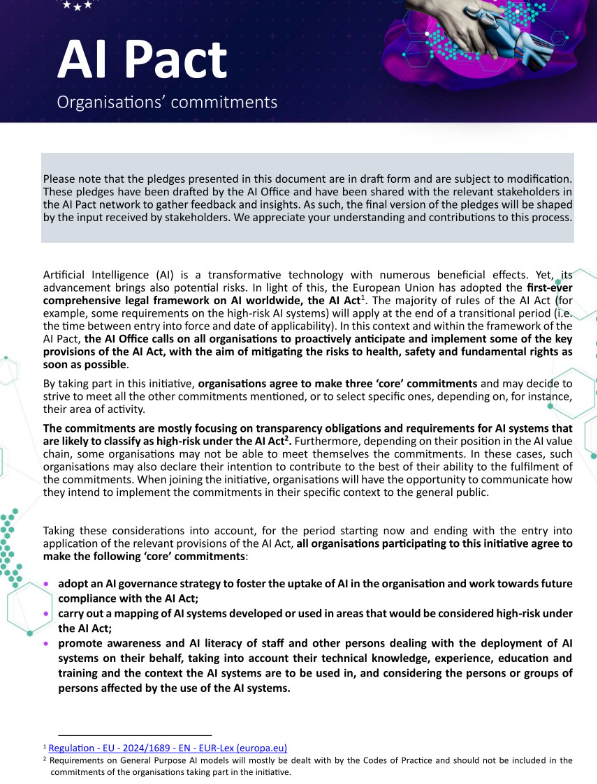

Fra gli aspetti salienti dell’AI Pact, i vantaggi dichiarati per la community di coloro che aderiscono. Di seguito alcune delle richieste avanzate alle organizzazioni aderenti, presenti nella bozza del patto.

Gli impegni richiesti

• effettuare una mappatura dei sistemi di IA sviluppati o utilizzati in aree che sarebbero considerate ad alto rischio la legge sull’IA;

• promuovere la consapevolezza e l’alfabetizzazione in materia di IA del personale e di altre persone che si occupano della diffusione dell’IA sistemi per loro conto, tenendo conto delle loro conoscenze tecniche, esperienza, istruzione e formazione e il contesto in cui devono essere utilizzati i sistemi di IA e considerando le persone o i gruppi di cui fanno parte persone interessate dall’uso dei sistemi di IA.

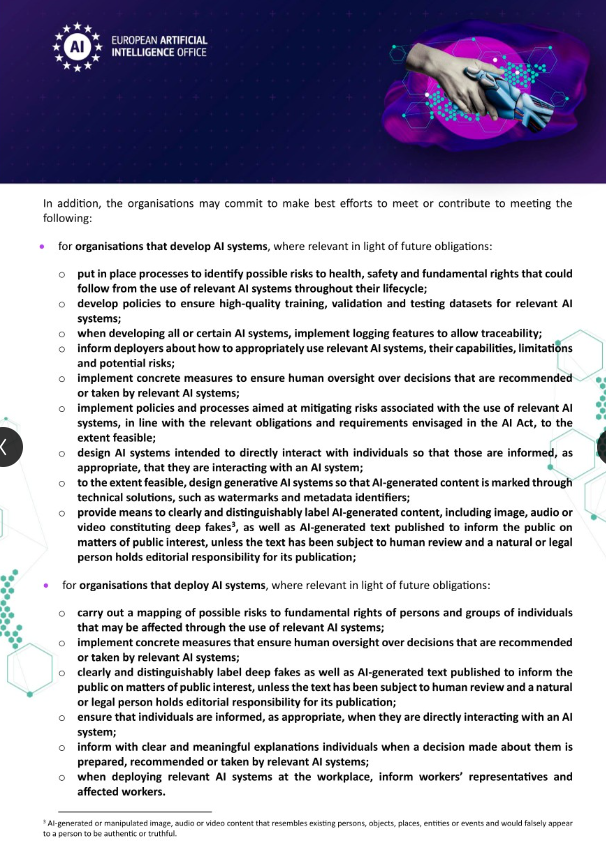

Inoltre, le organizzazioni possono impegnarsi a compiere ogni sforzo per soddisfare o contribuire a soddisfare le esigenze seguente:

• per le organizzazioni che sviluppano sistemi di IA, ove rilevante alla luce degli obblighi futuri:

o mettere in atto processi per identificare i possibili rischi per la salute, la sicurezza e i diritti fondamentali che potrebbero derivano dall’uso dei pertinenti sistemi di IA durante tutto il loro ciclo di vita;

o sviluppare politiche per garantire formazione, convalida e test di set di dati di alta qualità per l’intelligenza artificiale pertinente sistemi;

Tracciabilità

o quando si sviluppano tutti o alcuni sistemi di intelligenza artificiale, implementare funzionalità di registrazione per consentire la tracciabilità;

o informare gli operatori su come utilizzare in modo appropriato i sistemi di intelligenza artificiale pertinenti, le loro capacità e i limiti e potenziali rischi;

o implementare misure concrete per garantire il controllo umano sulle decisioni raccomandate presi dai sistemi di IA pertinenti;

o implementare politiche e processi volti a mitigare i rischi associati all’uso dell’intelligenza artificiale rilevante sistemi, in linea con i pertinenti obblighi e requisiti previsti dalla legge sull’AI, al misura fattibile;

o progettare sistemi di intelligenza artificiale destinati a interagire direttamente con gli individui in modo che siano informati, come opportuno, che stiano interagendo con un sistema di intelligenza artificiale;

o nella misura del possibile, progettare sistemi di intelligenza artificiale generativa in modo che il contenuto generato dall’intelligenza artificiale sia contrassegnato da soluzioni tecniche, come filigrane e identificatori di metadati;

o fornire mezzi per etichettare in modo chiaro e distinguibile i contenuti generati dall’intelligenza artificiale, comprese immagini, audio o video che costituisce un falso profondo, nonché testo generato dall’intelligenza artificiale pubblicato per informare il pubblico questioni di interesse pubblico, a meno che il testo non sia stato sottoposto a revisione umana e naturale o legale la persona ha la responsabilità editoriale della sua pubblicazione;

Mappatura dei possibili rischi

• per le organizzazioni che implementano sistemi di IA, ove rilevante alla luce degli obblighi futuri:

o effettuare una mappatura dei possibili rischi per i diritti fondamentali delle persone e dei gruppi di individui che potrebbero essere influenzati dall’uso dei pertinenti sistemi di IA;

o implementare misure concrete che garantiscano il controllo umano sulle decisioni raccomandate presi dai sistemi di IA pertinenti;

o etichettare in modo chiaro e distinguibile i deep fake e i testi generati dall’intelligenza artificiale pubblicati per informare il pubblico pubblico su questioni di pubblico interesse, a meno che il testo non sia stato sottoposto a revisione umana e naturale o la persona giuridica detiene la responsabilità editoriale della sua pubblicazione;

o garantire che le persone siano informate, ove appropriato, quando interagiscono direttamente con un’IA sistema;

o informare con spiegazioni chiare e significative le persone quando viene presa una decisione che le riguarda preparati, raccomandati o adottati dai sistemi di IA pertinenti;

o quando si utilizzano sistemi di IA pertinenti sul posto di lavoro, informare i rappresentanti dei lavoratori e lavoratori colpiti.