Neuralink è la startup di Elon Musk, lanciata nel 2016, con la missione di mettere in comunicazione il cervello umano con l’intelligenza artificiale.

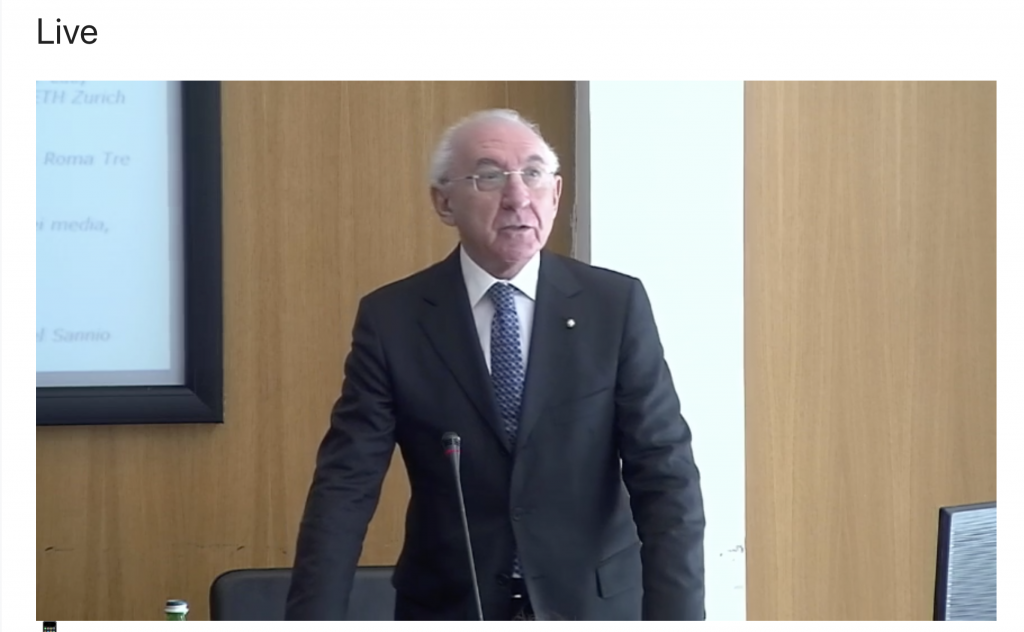

Occorre partire da qui per comprendere il monito lanciato oggi dal Garante privacy Pasquale Stanzione.

L’interfaccia cervello-computer

Il progetto di Neuralink punta a costruire un’interfaccia cervello-computer (Bci) che colleghi il cervello umano direttamente ai computer. La Bci è un impianto cerebrale, di solito un chip di elettrodi di pochi millimetri quadrati, che viene impiantato chirurgicamente direttamente nel cervello (si è partito con quello di un maiale). Gli elettrodi raccolgono l’attività elettrica dalle cellule cerebrali, dai neuroni e la trasmettono a un computer.

L’effetto negativo: leggere il cervello. Il neurocapitalismo

Questi chip nel cervello consentiranno di contenere gli effetti di patologie neurodegenerative ma, ecco l’effetto negativo, in un domani non lontano potranno leggere anche i pensieri e influenzare, addirittura, gli stati mentali e il comportamento, agendo direttamente sulla sfera neuropsicologica. In alcune scuole in Cina sono stati usati chip di neuro-monitoraggio per l’apprendimento degli alunni. Neuromonitoring obbligatorio per alcuni lavoratori nello stesso Paese. E già si parla di neuromarketing, caratterizzato da algoritmi per utilizzare le nostre emozioni e la predittività dei nostri pensieri.

I dubbi sulle neurotecnologie

“Il così rilevante incremento del potere epistemico di queste applicazioni neurotecnologiche solleva interrogativi”, ha chiarito Pasquale Stanzione, nel corso del convegno “Privacy e neurodiritti: la persona al tempo delle neuroscienze”, organizzato quest’anno dal Garante per la privacy in occasione della 15ma Giornata europea della protezione dei dati personali per approfondire:

- la questione dell’incidenza delle neuroscienze e dell’intelligenza artificiale sul processo volitivo e, più in generale, cognitivo, delle persone, anche sotto il profilo delle responsabilità giuridiche.

Il brain reading

“Queste e altre forme di ‘brain reading’, lasciano dunque intravedere la possibilità, almeno in un prossimo futuro, di ‘lettura’ (ma anche condizionamento e persino predizione) di intenzioni, emozioni, asserzioni di verità”, ha messo in guardia il Garante, che ha detto, nettamente, sì all’uso delle neurotecnologie per l’uso terapeutico. No per l’hackeraggio del cervello.

“Sì per la cura di malattie neurodegenerative“

“Va promosso l’uso terapeutico di tali tecniche”, ha affermato, “ad esempio per la cura di malattie neurodegenerative, ben più problematico ne è l’uso a fini di potenziamento cognitivo. Si tratta non tanto e non solo del ‘pendio scivoloso’, quanto della definizione del limite oltre il quale non sia tollerabile andare, anche per non ingenerare nuove discriminazioni nei confronti di quanti potenziati non siano e non accettino di essere”.

Così, qualora le neurotecnologie fondate sul brain-reading, dunque con funzione essenzialmente analitico-descrittiva dovessero effettivamente riuscire a decodificare i contenuti mentali, si avrebbero implicazioni principalmente sotto il profilo della “trasparenza” – e quindi della visibilità – del pensiero. “Esse attingerebbero, dunque, alla dimensione della segretezza di quel foro interno, la cui inaccessibilità è garantita in ogni ambito”, ha ricordato Stanzione.

Le tecnologie capaci, invece, di apportare condizionamenti al processo neurale, porrebbero invece essenzialmente un problema di libertà cognitiva come presupposto dell’autodeterminazione individuale.

“Il rischio? Non solo l’hackeraggio del cervello, ma la legittimità etica”

Uno degli effetti negativi delle neurotecnologie è il brain hacking.

“Il rischio”, ha evidenziato Stanzione, “non è tanto e non è solo quello dell’hackeraggio del cervello quanto, prima ancora, quello dell’ammissibilità (in primo luogo) etica di un intervento eteronomo sul processo cognitivo, sinora immune da ogni interferenza esterna”.

Come difendere le persone dall’uso improprio delle neurotecnologie?

Allora come difendere le persone dall’uso improprio delle neurotecnologie?

La risposta sono i neurodiritti, ha indicato il Garante.

“Neurodiritti da creare ad hoc o da desumere dalle norme attuali, perché sono l’argine essenziale all’uso improprio delle nuove tecnologie”, ha detto Stanzione.

È chiaro, quindi, il monito dell’Autorità per la protezione dei dati personali: tutto ciò che è tecnicamente possibile non è anche giuridicamente lecito ed eticamente fattibile. Ed in Italia l’uso improprio delle future neurotecnologie dovranno prima essere vagliate dal Garante privacy. La scienza, solo se guidata dal diritto e dall’etica, può rendere la vita migliore.

Da qui la proposta lanciata, infine, dal Garante. “C’è la necessità di uno Statuto giuridico con neurodiritti, privacy ed etica”.