Il Garante Privacy non si tira indietro di fronte alle sfide epocali che pone l’intelligenza artificiale e, nel giorno dell’apertura dell’indagine sulla cinese DeepSeek, snocciola sul tavolo tutte le questioni aperte dalla nuova tecnologia che sta rivoluzionando tutto. L’occasione è il convegno organizzato a Palazzo san Macuto per celebrare la Giornata europea dei dati personali.

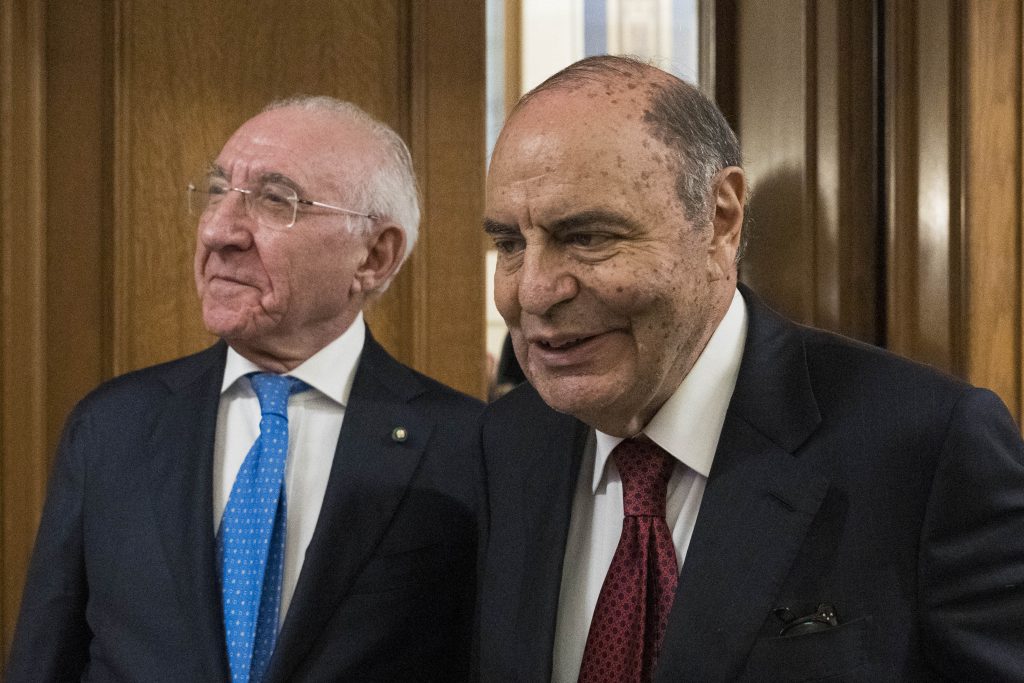

Parterre d’eccezione, con due ministri Calderone (Lavoro) e Schillaci (Sanità) in presenza, Crosetto (in video registrato) e Butti, sottosegretario alla trasformazione Digitale, anch’egli in registrazione da remoto.

La sfida, come detto, è epocale fra vantaggi innegabili dell’AI in alcuni ambiti a partire dalla sanità, passando per la cultura e l’istruzione. Ma i rischi non sono secondari, con l’allarme che arriva dal mondo della Giustizia – contrario all’introduzione dell’AI come sostituto tout court del magistrato e degli avvocati in fase dibattimentale – e il rischio latente di tagliare milioni di posti di lavoro e di instaurare una sorta di delega in bianco alla macchina di intere fette strategiche della nostra esistenza e del funzionamento del sistema. Basteranno l’AI Act e il GDPR a regolare l’AI?

AI, Stanzione: ‘Non dobbiamo cedere al dominio della macchina’

“L’uso improprio dei dati è un sopruso, proteggere i dati personali vuol dire proteggere la democrazia”, ha detto la vicepresidente del Senato Anna Ascani. Come darle torto, anche se nel giorno di DeepSeek, la risposta cinese low cost a ChatGPT e del faro accesso dal Garante sull’azienda, quello che emerge in tutta la sua evidenza è il costante ritardo delle norme nell’arginare fenomeni tecnologici che come tsunami investono le nostre vite.

Stanzione: ‘AI Act come le colonne d’Ercole per limitare la macchina’

Lo sa bene il Presidente del Garante Privacy Pasquale Stanzione, che pone la domanda fatidica: “Come farà l’uomo a non essere dominio della macchina?”. Una tragica consapevolezza del rapporto da sempre problematico fra uomo e macchina. Un nodo irrisolto, dalle radici antiche. Il rischio di Hybris è dietro l’angolo. “Il mercato dell’AI è cresciuto del 52% nel 2024, il 64% delle aziende ci sta investendo. Il 65% degli studenti la usa per fare i compiti”, dice Stanzione, precisando che gli aspetti più preoccupanti riguardano lo sviluppo autonomo e l’uso bellico. “Le armi autonome potrebbero diventare le nuove bombe autonome (momento Hoppenheimer)” con l’aggravante che il monopolio dell’informazione rappresenta oggi la nuova guerra fredda globale. “Dobbiamo tracciare delle colonne d’Ercole perché la tecnica resti al servizio dell’uomo”, dice il Garante. L’AI Act rappresenta questo tentativo. Anche se non sarà una passeggiata, nel momento in cui Meta rifiuta il fact checking. Ma non si può delegare la legge ai social e per questo è auspicabile anche un altro effetto il cosiddetto “Bruxelles effect”, vale a dire la deterrenza normativa della Ue. Basteranno l’AI Act e il GDPR a regolare l’AI?

Scorza: ‘La nuova corsa agli armamenti digitali fra Cina e Usa appena partita’

“Siamo in un’epoca liquida, non più panta rei (tutto scorre), ma panta tei (tutto corre)”, dice Guido Scorza, componente del Garante Privacy, sottolineando che lo sviluppo tecnologico galoppa sempre più veloce ed è un cavallo sempre più difficile da tenere. “ChatGPT ha raggiunto 100 milioni di utenti in due mesi, il doppio di Youtube”, dice Scorza. Cosa succederà con DeepSek, l’emulo cinese di ChatGPT?

In un contesto del genere anche la migliore delle normative sull’AI rischia di essere obsoleta prima del nuovo salto tecnologico. “La nuova corsa agli armamenti digitali dell’AI fra Cina e Usa è appena partita”, aggiunge Scorza, secondo cui non vale la pena normare nel dettaglio, servono dei principi di massima che non vengano superati da uno sviluppo tecnologico fulmineo. Senza per questo rinunciare a normare, per non lasciare campo libero alla tecnocrazia.

Frattasi (ACN): ‘Previste delle sand box normative per lo sviluppo dell’AI’

Certo, è innegabile che la regolazione arranca per tenere il passo. L’AI Act, è stato criticato per l’attenzione posta sulle regole a discapito dello sviluppo. Tuttavia, l’Europa ha introdotto misure di sostegno come le sandbox normative, spazi di sperimentazione controllata per favorire l’innovazione. Questi ambienti protetti permettono alle aziende di testare prodotti e servizi riducendo i rischi normativi e saranno gestiti in Italia da ACN e Agid. “L’AI Act è una risposta – ha detto il direttore generale dell’ACN Bruno Frattasi – la Ue creerà delle sand box normative, degli spazi verticali, anche transfrontalieri, per lo sviluppo e la sperimentazione dell’AI. Il decreto italiano sull’AI le prevede. Ma bisogna coinvolgere tutte le autorità e bisogna farlo anche per altre tecnologie come la blockchain”.

Nobile (Agid): ‘Non ci sono soltanto usi distorti dell’AI’

L’Italia è un paese forte, secondo Mario Nobile, direttore generale dell’Agid. “La nostra ricerca di base è la settima al mondo nell’informatica ed esportiamo 600 miliardi di prodotti e merci all’anno”.

Cosa ci manca allora? “La velocità o meglio l’adattamento”, risponde Nobile. Un esempio? L’AI Act è pronto dal 2021 ma non è ancora in vigore. “Ma non ci sono soltanto usi distorti dell’AI”, dice Nobile ricordando il ruolo centrale della tecnologia per individuare tumori e malattie in genere. Trump ci ha messo una settimana a cancellare l’executive order di Biden sull’AI. Ora vedremo che succederà.

Cerrina Feroni: ‘Inammissibile disumanizzare la funzione giudiziaria’

“Una tecnologia come l’AI necessita di una frontiera – ha detto Ginevra Cerrina Feroni, Vicepresidente del Garante Privacy – ma è possibile individuare un limite alla volontà di potenza delle AI?”. Di certo, è necessaria una valutazione d’impatto per gli usi ad alto rischio. Giustizia, Difesa e law enforcement sono dei punti centrali. “L’Uso dell’AI in ambito investigativo impone controlli rispetto all’analisi di somiglianze massive. Lo stesso vale per la polizia predittiva e la categorizzazione biometrica”, aggiunge. Di certo, “il sistema legale con funzione giudiziaria non può essere disumanizzato – aggiunge Cerrina Feroni – il rischio di bias è inaccettabile. Sostituire decisioni umane con quelle della macchina in fase processuale è inammissibile”. In altre parole, la tecnica non può rappresentare un fattore di competitività giudiziaria.

Wanda Ferro: ‘Ruolo importante dell’AI per le forze dell’ordine’

La sottosegretaria al Ministero dell’Interno Wanda Ferro si è soffermata sull’uso dell’AI da parte delle forze dell’ordine. “L’AI consente di analizzare una miriade di dati da fonti molteplici – ha detto Ferro – dal riconoscimento facciale a quello vocale. Si tratta di strumenti utili nella prevenzione di crimini”. Il ruolo dell’AI è centrale anche nella sicurezza informatica delle infrastrutture critiche per fronteggiare attacchi cyber sempre più sofisticati. “Ma attenzione alle allucinazioni dell’AI, che possono indurre a decisioni errate – aggiunge Ferro – anche per questo servono un approccio normativo e regole chiare. Il percorso che si sta facendo con un disegno di legge incardinato al Senato”. Un provvedimento che prevede il concerto di una decina di ministri. Non sarà una passeggiata.

Pucciarelli (Lega): ‘In Commissione ci stiamo occupando dei ragazzi’

“In Commissione ci stiamo occupando dei ragazzi – dice Stefania Pucciarelli, senatrice della Lega Presidente della Commissione straordinaria per la tutela e la promozione dei diritti umani, già Sottosegretario di Stato alla Difesa – stiamo facendo una indagine conoscitiva sul tema dell’AI e alla luce dell’arrivo sul mercato di DeepSeek dovremmo certamente fare degli aggiornamenti in Commissione”. Diverse le questioni aperte sull’uso dell’AI. Se da un lato, in ambito cardiaco, l’AI permette di ridurre del 30% il rischio infarto, la domanda aperta è se le cose vanno male, di chi è la colpa? Della macchina o del medico? Oltre all’ambito sanitario c’è anche quello umanitario.

Paolo Sisto: ‘AI nella giustizia ancillare. Decisioni vanno prese rigorosamente dal magistrato’

Il viceministro alla Giustizia Paolo Sisto pone l’accento sui rischi connessi ad un uso indiscriminato dell’AI in ambito giudiziario. “Le decisioni devono essere prese rigorosamente dal magistrato – dice Sisto – l’intelligenza artificiale inoltre mortifica il principio di oralità. Le aule giudiziarie sono vuote, le udienze sono state sostituite dalle note scritte. Manca la presenza fisica dell’avvocato e del giudice, ma la presenza davanti al giudice fa la differenza. Per la professione dell’avvocato questo è importante”. Il viceministro dice ancora che l’avvocato deve scrivere i provvedimenti di suo pugno e non delegare alla macchina. “L’AI può servire in fase organizzativa, di ricerca delle sentenze, con funzione ausiliaria di cancelleria”, aggiunge Sisto che esprime preoccupazione contro la possibilità di fabbricare prove false con l’AI.

Gli fa eco il ministro della Difesa Guido Crosetto, che non nasconde la sua preoccupazione sugli sviluppi futuri dell’AI che “potrà presto auto modificarsi”. Il che potrebbe rendere impossibile spegnere le macchine, anche perché non è possibile cosa saranno in grado di fare in futuro.

Dal canto suo, Agostino Ghiglia, componente del Garante Privacy, richiama alla necessità di diffondere una sorta di educazione civica digitale anche in ambito scolastico, dove un eccesso di AI rischia di danneggiare studenti e insegnanti. In diversi ambiti come lavoro, cultura e sanità è necessario valutare pro e contro della nuova tecnologia. “Ma in tutti i casi bisogna garantire che l’intervento umano non sia marginale”, dice Ghiglia.

Orazio Schillaci: ‘AI fantastica in sanità, ma va governata’

Il ministro della Salute Orazio Schillaci si concentra sul ruolo dell’AI in ambito sanitario, che peraltro rappresenta il 50% del suo utilizzo complessivo sul mercato. “E’ uno strumento fantastico, ma qualunque innovazione in sanità deve essere per tutti. L’AI deve diminuire la disparità, non possono esserci ospedali che hanno l’AI e la usano e altri che non ce l’hanno”. L’AI in campo terapeutico promette di migliorare le cure in modo sostanziale, ad esempio per quanto riguarda l’anatomia patologica. Ci sono- dei software, ricorda il ministro, in grado di sostituire l’uomo e lo stesso vale nella diagnostica per immagini, dove l’AI può arrivare a vedere delle anomalie di dimensioni piccolissime “che sfuggono all’occhio del radiologo più esperto”. “L’AI può servire per scoprire nuovi farmaci; può facilitare il lavoro dei chirurghi; può rendere più facile un consulto medico. Ma va governata”, chiosa il ministro.

AI, Frassinetti (FdI): monitorare utilizzo nelle scuole

“Il Ministero dell’Istruzione e del Merito partendo dalla piattaforma Unica realizzata con il parere favorevole del Garante, e pensata per gestire la modalità di trattamento dei dati, sta programmando l’inserimento di una apposita sezione per rilevare le sperimentazioni dell’Intelligenza artificiale nelle scuole in grado di individuare risultati e misure di sicurezza adottate. Il decreto, nell’ambito del progetto in tema di Intelligenza artificiale nelle scuole, sarà il primo grande risultato applicativo in grado di valorizzazione e di monitorare, nel rispetto dei limiti posti dalla normativa europea, tipologie dei dati trattati, finalità del trattamento, modalità di accesso degli utenti, modelli documentali in materia di data protection, nonché l’adozione di specifiche linee guida sull’impiego dell’Intelligenza artificiale nelle attività didattiche da indirizzare alle Istituzioni scolastiche e ai rispettivi Responsabili della protezione dati al fine di garantire il monitoraggio da parte della Struttura centrale”, ha detto il Sottosegretario all’Istruzione e al Merito Paola Frassinetti.

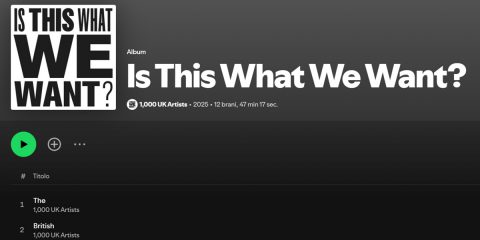

Salvatore Sica: ‘GenAI ha bisogno bulimico di dati per addestrare l’algoritmo’

Dal canto suo, l’avvocato Salvatore Sica, ordinario di Diritto pubblico all’università di Salerno e giurista dell’informazione, consulente giuridico del ministero della Cultura, punta il dito contro le perdite che l’AI produrrà nei prossimi anni in ambito di copyright: 22 miliardi di euro nel prossimo biennio secondo un report della confederazione europea degli autori ed editori. “La GenaAI ha bisogno bulimico di dati in fase di addestramento – dice Sica – e in questa fase vengono usati costantemente contenuti coperti da copyright”. Ma l’AI non dovrebbe pagare i diritti? Il risultato dell’addestramento può essere considerato un contenuto autorale? Di norma, l’AI è escluso come autore. Ma in realtà non è poi così certo. Resta il fatto che l’open access ai contenuti, al momento, conviene alle Big tech per l’addestramento degli algoritmi. Ma la creatività va remunerata.

Butti, ‘per la protezione dei dati servono standard globali’

“Le soluzioni adottate finora” per la protezione della privacy di fronte allo sviluppo tecnologico “non sono perfette”. Lo ha detto il sottosegretario con delega alle Comunicazioni Alessio Butti.

“La prima è quella della iper regolamentazione pubblica – ha sottolineato -, ma questo scenario ha offerto poche garanzie sulla tutela. Le leggi dovrebbero riuscire a imporre alle aziende la cancellazione di dati non utilizzabili, ma siamo ancora molto lontani da questo risultato. Il secondo scenario è quella della autoregolamentazione da parte delle aziende, ma al di là dei proclami finora queste ultime si sono dimostrate per nulla interessate a questo approccio, consapevoli del fatto che il venir meno di un approccio sulla monetizzazione dei dati intaccherebbe i loro modelli di business”.

Butti ha fatto l’esempio di Meta, che ha detto stop al fact checking. “Ma che credibilità possono avere aziende che si comportano così?”.

“Occorre un equilibrio tra le varie esigenze – ha detto ancora -. Si può trovare con la collaborazione e con la cooperazione. Servono standard globali condivisi, perché la regolamentazione da sola non basta. Serve un’innovazione responsabile per proteggere i dati fin dalla progettazione di una nuova tecnologia. Infine è fondamentale il coinvolgimento dei cittadini”.

Calderone, ‘L’AI non farà perdere posti di lavoro’

“Avremo difficoltà per quanto riguarda alcune professionalità che risentono della mancanza di formazione e riqualificazione, ma non credo che l’intelligenza artificiale provocherà perdite di posti di lavoro – ha detto la ministra del Lavoro Marina Calderone – Noi dobbiamo investire in riqualificazione: le offerte di lavoro ci sono, parliamo di 1 milione e mezzo di posti al mese, e abbiamo difficoltà di reperire lavoratori qualificati”, ha aggiunto, “Io vedo grandi opportunità se sapremo sfruttare le modalità con cui possiamo far incrociare domanda e offerta di lavoro”. “E’ importante dotarsi di strumenti tecnologicamente avanzati per comprendere e leggere in fenomeni in atto. Servono scelte di campo: nel documento prodotto al G7 abbiamo detto che l’IA è cruciale ma che serve dare una lettura umanocentrica”, ha aggiunto Calderone, ‘l’intelligenza artificiale può distruggere posti se non garantiamo di utilizzarla come strumento e supporto. Noi dobbiamo creare modelli e norme senza ingabbiare l’innovazione ma accompagnandola, attuando le norme dell’IA europeo. Stiamo costruendo l’Osservatorio dell’impatto dell’IA sul mercato del lavoro per valutare attentamente le modalità con cui sono gestiti i processi decisionali dando una visione etica al nostro agire. Importante valorizzare un principio di trasparenza quando si usa una mole di dati così importante”.