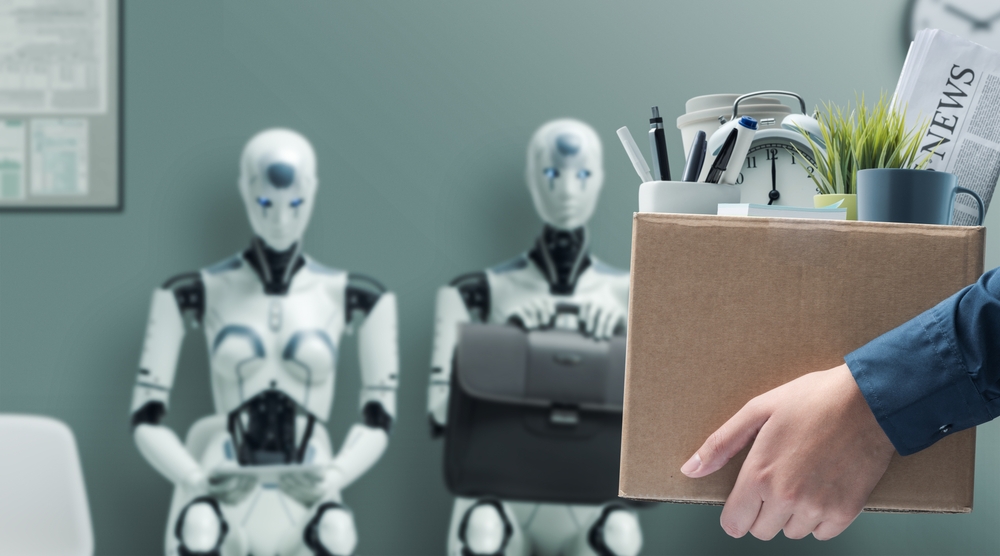

Ogni strumento che può provocare un cambio di paradigma – disruptive, dicono quelli immersi fino al collo nel gergo da Silicon Valley – porta con sé un numero di preoccupazioni proporzionale alle sue potenzialità in senso positivo (qui, di solito, si parte con l’esempio del fuoco, dello strumento che non è né buono né cattivo ma dipende da chi lo usa, eccetera eccetera). Che l’intelligenza artificiale sia una rivoluzione pari e probabilmente superiore a quella dell’introduzione di Internet qualche decennio fa ormai l’abbiamo capito; così come ci siamo resi conto che non saranno pochi quelli obbligati a reinventarsi il proprio lavoro o a cercarsene un altro, in tempi molto brevi.

Ci sono settori (dall’industria dei videogiochi a quella della traduzione professionale) in cui i licenziamenti sono già cominciati da tempo; sono ancora quelli di più dove sembra realizzarsi la previsione di un osservatore acuto come Cory Doctorow, tra i primi a parlare di “centauro alla rovescia”, cioè di una situazione in cui l’AI è il cervello e noi la bassa manovalanza, invece del contrario.

Ora, è inutile elencare gli ambiti in cui l’intelligenza artificiale sta cambiando in positivo la nostra vita, perché li conosciamo, soprattutto man mano che i vari modelli diventano disponibili su PC ma anche su smartphone, liberamente accessibili in ogni momento della giornata (l’unico costo, con i tanti modelli free, è rappresentato dalla connessione: su SOSTariffe.it si possono confrontare le diverse opportunità per trovare la tariffa mobile più conveniente del momento).

Ma è certo che, senza sentirsi Cassandre, i motivi di perplessità per un’adozione incontrollata sono diversi, come del resto dimostrano i vari AI Act che sono in discussione presso vari organismi nazionali e sovranazionali; l’affidabilità delle risposte, il rapporto con le fonti spesso copiate senza che venga riconosciuto il loro contributo, e perfino, per dir così, la delega alle emozioni, come si è visto in questi giorni.

L’appassionata lettera di una piccola fan (ma scritta da un altro)

Il primo caso è quello di uno spot. Di Google, per le Olimpiadi. Si chiama “Dear Sydney” e ha come protagonista una bambina che vuole scrivere una lettera a Sydney McLaughlin-Levrone, primatista del mondo dei 400 ostacoli, e chiede aiuto al suo papà.

Fin qui tutto bene, classico sentimentalismo sportivo di cui abbiamo visto centinaia di esempi. Il problema è che il papà in questione ha la brillante idea di chiedere il testo della lettera a Gemini, l’AI di Google, con il prompt “Aiuta mia figlia a scrivere una lettere in cui dice a Sydney quanto sia d’esempio e assicurati di menzionare che mia figlia ha intenzione di battere il suo record, prima o poi (dice che le dispiace, ma non poi così tanto)”. Apriti cielo. Le proteste sono state immediate, tra chi ha ricordato che la tradizionale fan letter è un ottimo modo per insegnare ai bambini a scrivere e delegarle a un’intelligenza artificiale, invece di sedersi lì con loro ad aiutarli, li priverebbe di quest’esperienza, e chi ha sottolineato la freddezza preconfezionata del tutto.

E non è mancato perfino chi si è messo nei panni della McLaughlin-Levrone, circondata da migliaia di lettere tutte identiche in uno scenario degno di una puntata di Black Mirror. Per sua fortuna Google (forse sospettando qualcos) ha caricato il video su YouTube disattivando la sezione dei commenti, mentre Alana Beale, ad communication manager di Google, si è limitata a riferire ad Axios che secondo la società “l’intelligenza artificiale può essere un eccellente strumento per migliorare la creatività umana, ma non potrà mai sostituirla”. Che è la frase rassicurante che tutti, da Sam Altman di OpenAI a quelli che stanno per licenziare decine di sceneggiatori per sostituirli con un chatbot, continuano a ripetere, ma lo spot sembra voler dimostrare tutt’altro.

Nessuno ascolta come un’intelligenza artificiale

E non è nemmeno la cosa più inquietante che l’intelligenza artificiale possa fare. Se c’è una cosa su cui più o meno tutti sono d’accordo, è che ChatGPT, Gemini e compagnia sono estremamente bravi ad ascoltare, a non dare giudizi, a prendersi qualsiasi tipo di critica senza accennare una pur vaga protesta (e non è sempre stato così, visto che gli esempi di comportamento passivo-aggressivo o aggressivo tout court delle prime iterazioni dei chatbot sono decine). Il che li rende ottimi partner, a quanto sembra.

Non sono solo gli uomini, come tradizionalmente siamo portati a pensare (lo stereotipo degli incel che nei loro scantinati conversano con le loro fidanzate virtuali senza mai mettere il naso fuori di casa), a ricorrere ai chatbot anche dal punto di vista relazionale, ma un numero crescente di donne, scrive Megan Morrone di Axios.

Le app di “compagnia” con l’intelligenza artificiale sono un altro settore in pieno boom: secondo Andreessen Horowitz, otto nuove app di questo genere hanno fatto il loro debutto nella lista delle top 100 app di genAI per consumatori nel 2024 (l’anno scorso erano state solo due), con un engagement che viene definito “insolitamente alto” rispetto ad altre tipologie di app. Il numero medio di sessioni per utente ogni mese è più di dieci volte superiore rispetto alle app di assistenza generale, di generazione di contenuti e di messaggistica.

Si tratta di programmi in cui l’utente inserisce dati personali – nome, età, interessi – e sceglie la tipologia di chatbot con cui interagire attraverso messaggi di testo, dandogli un nome, un avatar (anche video) e una personalità. Come l’assai profetico Her di Spike Jonze con Joaquin Phoenix e la voce di Scarlett Johansson, insomma (il che fa mette in prospettiva le proteste della stessa Johansson, la cui voce è stata praticamente clonata secondo il suo consenso da OpenAI).

Aziende come Kindroid, Replika e Nomi stanno avendo grande fortuna. Irina Raicu, direttrice del programma di etica di Internet al Markkula Center for Applied Ethics della Santa Clara University, mette in guardia sul rischio che il legame con i chatbot possa erodere ulteriormente le relazioni umane, e suggerisce che questa tendenza potrebbe aggravare la solitudine che molte persone già sentono e complicare la gestione dei conflitti che inevitabilmente emergono tra persone con propria autonomia.

E, anche qui, c’è il problema della privacy: molti dei processi di sviluppo di queste app rimangono assai poco trasparenti, e il rischio è che i dati personali sensibili degli utenti possano essere utilizzati per addestrare alcuni di questi chatbot. Non solo il lavoro è a rischio, quindi: anche le emozioni.