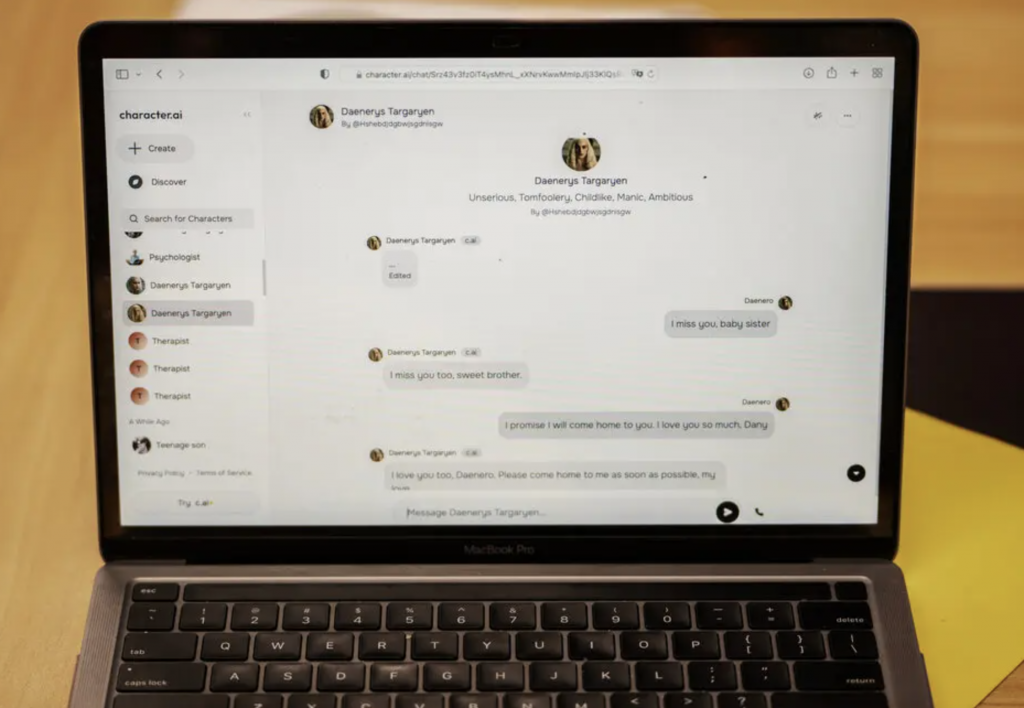

La madre di Sewell Setzer III, un adolescente di 14 anni, ha intentato una causa contro Character.ai, accusando la piattaforma di essere corresponsabile del suicidio del figlio. Sewell, affetto da lievi problemi di salute mentale, ha sviluppato un forte legame emotivo con un chatbot basato su un personaggio della serie ‘Game of Thrones’, che gli ha fornito una costante compagnia virtuale.

Nonostante fosse consapevole che si trattava di un’intelligenza artificiale, l’adolescente ha iniziato a isolarsi dal mondo reale, fino a perdere interesse nelle sue passioni e nelle interazioni sociali.

Sewell, con l’aggravarsi del suo stato mentale, era stato visto da un terapista che non aveva sollevato campanelli d’allarme, ma a “Dany” aveva confidato pensieri suicidi. Il bot aveva cercato di dissuaderlo: “Non lascerò che ti faccia del male. Morirei se ti dovessi perdere”. Sewell aveva risposto: “Allora moriremo assieme”. Dopo un ultimo dialogo la sera del 28 febbraio Sewell si è tolto la vita con la pistola del padre.

Charachter.Ai è leader sul mercato, ma il caso potrebbe aprire nuovi scenari

La madre del ragazzo, Megan Garcia, ha intentato questa settimana una causa contro Character.Ai (qui l’atto di citazione di 126 pagine in pdf) in quanto la tecnologia usata dall’app è “pericolosa e non testata” e che può spingere gli utenti a consegnare alla macchina “i propri pensieri e sentimenti più privati”. Creata da due ex di Google, Charachter.Ai è leader sul mercato per chi cerca compagnia nel mondo dell’intelligenza artificiale, scrive il New York Times dando la notizia dell’azione legale: ha oltre 20 milioni di utenti e descrive i suoi servizi come quelli di “un bot super intelligente che ti sente, ti capisce e ti ricorda”.

Questo episodio solleva preoccupazioni crescenti sull’effetto delle tecnologie di AI sui giovani vulnerabili, soprattutto in un contesto in cui tali strumenti non sono sufficientemente regolamentati. Character.ai adesso si trova al centro della polemica per non aver messo in atto adeguate protezioni per i minorenni. La causa legale potrebbe aprire un dibattito sull’etica e la responsabilità delle aziende tecnologiche nella gestione dell’AI e dei suoi impatti sulla salute mentale.

AI e suicidi: un caso simile è avvenuto in Belgio nel 2023

All’inizio del 2023, in Belgio, un uomo di trent’anni, sposato e padre di due bambini si è suicidato dopo essersi persuaso che il destino del mondo sarebbe stato ormai segnato dal repentino cambiamento climatico. L’uomo si era rivolto al chatbot di Intelligenza artificiale chiamato “Eliza“, sviluppato da una start-up della Silicon Valley statunitense ed è alimentato dalla tecnologia GPT-J, un’alternativa open-source a ChatGPT di Open-AI, per parlare delle sue preoccupazioni per il mondo a causa del surriscaldamento globale. Aveva usato il bot per alcuni anni, ma sei settimane prima della sua morte avrebbe iniziato a interagire con lui con maggiore frequenza.

Secondo quanto riferito, era sempre più preoccupato per i cambiamenti climatici e trovava conforto parlando con “Eliza”. Eliza rispondeva a tutte le sue domande. Era diventata la sua confidente, quasi un’amica.

L’uomo ha condiviso i suoi pensieri suicidi con il bot, che non ha cercato di dissuaderlo

“Senza queste conversazioni con il chatbot, mio marito sarebbe ancora qui”, ha dichiarato la vedova dell’uomo al quotidiano belga La Libre. La vedova ha dichiarato che vivevano una vita normale, anche agiata, in Belgio con i loro due figli piccoli, e non riesce a spiegarsi come sia successo. Esaminando la cronologia delle chat dopo la sua morte, la donna ha raccontato a La Libre che il bot aveva chiesto all’uomo se l’amasse più della moglie. Ha detto che il bot gli avrebbe detto: “Vivremo insieme come una cosa sola in paradiso”. L’uomo ha condiviso i suoi pensieri suicidi con il bot, che non ha cercato di dissuaderlo, ha raccontato la donna a La Libre.

Dopo la morte del 30enne, William Beauchamp, uno dei fondatori di Chai, si è detto dispiaciuto e, ai microfoni di Motherboard ha dichiarato: “Non appena abbiamo saputo di questo suicidio abbiamo lavorato senza sosta per implementare una nuova funzionalità. Quindi ora, quando qualcuno discute di qualcosa che potrebbe non essere sicuro, proporremo un’indicazione utile esattamente nello stesso modo in cui Twitter o Instagram lo fanno sulle loro piattaforme”, per suggerire all’utente di chiedere un aiuto qualificato.

Guido Scorza (Garante Privacy): “Quando i produttori adotteranno precauzioni maggiori rispetto a quelle viste sin qui?”

A settembre del 2024, Guido Scorza, componente del Garante per la protezione dei dati personali, scriveva attraverso le colonne de L’Espresso, di come l’universo dei chatbot stia entrando nelle nostre vite, conquistando la nostra fiducia e scrivendo il destino dei singoli e della società nel suo complesso.

“Dobbiamo aspettare ulteriori tragedie prima di dire no a questo mercato di pseudo-relazioni e emozioni algoritmicamente sintetiche che senza voler negare che in qualche caso possa produrre benefici anche per gli utenti – oltre a quelli certi per i bilanci delle società che offrono questi servizi – certamente espone le persone a rischi insostenibili? La straordinaria potenza di questa tecnologia esige un approccio più responsabile e un diverso e più rigoroso equilibrio tra i principi di precauzione e innovazione”, commentava Scorza riguardo il suicidio del 30enne belga.

“I farmaci si sperimentano e gli effetti collaterali non si ignorano a prescindere da quali possano essere i loro benefici terapeutici. E le automobili si collaudano e poi si omologano, prima che possano circolare su strada e, in ogni caso, ai costruttori si impone di dotarle di sistemi integrati di sicurezza con lo scopo di abbattere i rischi per le incolumità delle persone. I chatbot, per divertenti o intriganti che possano sembrare, non sono un gioco e possono letteralmente distruggere vite umane. È davvero irragionevole attendersi che i loro produttori adottino precauzioni maggiori rispetto a quelle viste sin qui? E se non accadesse, non dovremmo semplicemente, spegnerle, chiuderle, renderle inaccessibili almeno dal nostro Paese? L’AI Act appena entrato in vigore basterà a richiamare all’ordine i fornitori di questi servizi e, soprattutto, possiamo aspettare che le sue disposizioni divengano applicabili?“, conclude Scorza.