Recentemente ho ricevuto una notifica di Facebook che mi informava di aver rimosso un mio post in violazione dei Community Standards. Ironia della sorte, si trattava di un semplice rimando ad una presentazione del mio libro “Molto social, troppo dark”, fatta presso il Forum PA nei giorni precedenti. Un evidente errore dell’AI, a fronte del quale, tuttavia, sono riuscito a far ripristinare il post solo attraverso contatti informali con la Piattaforma, dato che per i canali preposti (form di assistenza) era stato impossibile anche solo ricevere un riscontro.

Questo episodio personale mi ha spinto a chiedermi cosa stesse succedendo rispetto ai contenuti di odio, disinformazione ed ai relativi processi di rimozione automatizzata. Dopo poche ricerche sul motore, ecco aprirsi la pagina di Meta dedicata alla trasparenza. A mio avviso è stata una lettura interessante, tra “evidenze” piuttosto ovvie, ma anche sorprese e nuovi possibili trend. Vediamone alcuni.

Dalla lettura “storica” offerta dalla pagina emerge che, dopo trimestri da record nel 2021 per il blocco di commenti e post offensivi, Meta ha rimosso o segnalato circa 16 milioni di contenuti contenenti hate speech su Facebook e Instagram solamente tra gennaio e marzo del 2024, mantenendo, di fatto, livelli di rimozione simili all’anno e al trimestre precedente.

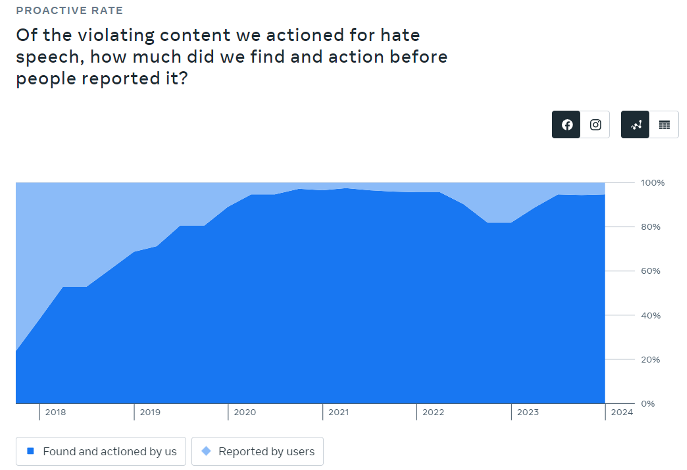

Nonostante il team mondiale di 15.000 “pulitori” che Meta continua a riproporre come best practice e a riprova del suo sforzo massimo (anche economico) di tenere in ordine la sua piattaforma, quello che spicca realmente è il ruolo proattivo dell’AI nella rimozione dei contenuti. Per quanto riguarda Facebook si è passati dal 23.6% di contenuti segnalati dall’AI nel 2017 al 94.7% nel 2024. Le percentuali di Instagram sono totalmente assimilabili.

Grafico 1 (Fonte: Transparency Center, Meta)

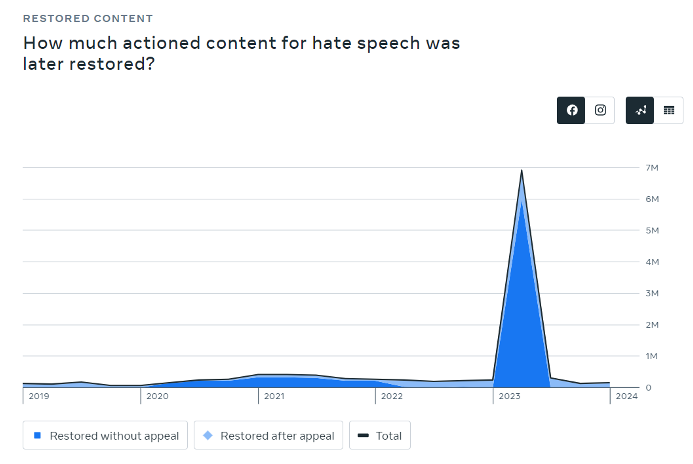

Affidarsi pesantemente agli algoritmi ha però i suoi svantaggi, pratici oltre che etici. Colpiscono, infatti, i dati relativi alle richieste di “ripristino” dei contenuti avanzate dagli utenti (situazioni simili alla mia, di cui ho accennato a inizio articolo). In questo caso i dati delle piattaforme controllate da Meta divergono sostanzialmente: si passa da 1.2 mln di contenuti per Facebook ai 2.2 mln per Instagram. Anche i dati sul ripristino sono interessanti: nel primo trimestre del 2024, 148.000 contenuti rimossi per discorsi di odio sono stati successivamente ripristinati, 145.000 dei quali attraverso processi automatici che non richiedevano un appello manuale.

La relazione tra i contenuti segnalati e successivamente ripristinati è particolarmente sorprendente tra aprile e giugno 2023 per entrambe le piattaforme con un picco del quale non viene data alcuna spiegazione.

Grafico 2 (Fonte: Transparency Center, Meta)

Da quando Meta ha iniziato a pubblicare il suo Rapporto sull’Applicazione degli Standard della Comunità ogni trimestre per creare maggiore trasparenza riguardo alle loro misure di moderazione, la quantità totale di contenuti segnalati o rimossi contenenti discorsi di odio, così come il suo tasso di azione proattiva, ha raggiunto un picco storico nel secondo trimestre del 2021 e ha iniziato a diminuire costantemente fino al primo trimestre del 2023, dopo di che è brevemente risalito ai livelli del 2021. Vedremo come evolveranno le dinamiche che abbiamo appena descritto, sicuramente occorrerà monitorarle. Più importante è continuare a chiedersi (e chiedere) dove è rimasto l’umano in tutto questo.