Conoscono talmente bene i robot, perché li costruiscono, che mettono in guardia il mondo dai loro ‘effetti destabilizzanti’. Così più di 100 leader delle industrie dell’IA e della robotica hanno scritto e firmato una lettera indirizzata all’Onu per invitarla a fermare la corsa alle armi basate sull’intelligenza artificiale. In sostanza a bloccare il prima possibile la diffusione di soldati-robot, di robot-killer.

I 116 fondatori e responsabili dell’industry del settore hanno lanciato quest’allarme “perché le tecnologie dell’intelligenza artificiale e della robotica possono essere utilizzate per sviluppare armi autonome”, che, se non fermate, potrebbero dar vita alla “terza rivoluzione bellica, dopo la polvere da sparo e le armi nucleari”.

L’appello è stato lanciato in occasione del 1^ meeting (poi rimandato) del gruppo di esperti governativi (Gge) sui sistemi di armi letali autonome. Tra i firmatari della lettera figurano anche il Ceo di SpaceX, Elon Musk. Il fondatore della compagnia aerospaziale ‘privata’ e Ceo anche di Tesla Motors già a luglio ha espresso pubblicamente le sue paure su un uso non corretto dell’IA: le auto a guida autonoma corrono il rischio di attacchi informatici e l’intelligenza artificiale prenderà il sopravvento sull’uomo…per questo motivo occorre intervenire in modo proattivo a regolamentare i robot con IA”.

Il vaso di Pandora

Questa non è la prima volta che i leader del settore mettono in guardia l’Onu e il mondo dalle conseguenze negative e disastrose che potrebbero verificarsi con le armi intelligenti. È avvenuto anche nel 2015. Due anni fa la lettera conteneva questo appello: “Iniziare una corsa alle armi basate sull’intelligenza artificiale è una cattiva idea e va prevenuta col divieto sulle armi autonome offensive, prive di un significativo controllo umano”. Allora sono stati oltre 2.400 ricercatori di intelligenza artificiale e robotica, molti italiani, che hanno firmato la lettera aperta per incitare le Nazioni Unite a proibire e prevenire la corsa alle armi autonome.

Le armi intelligenti

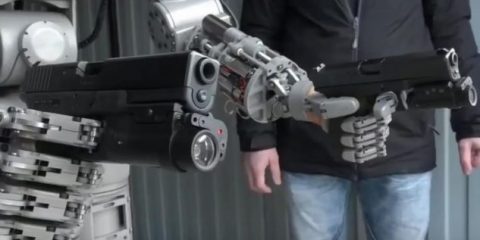

Le armi autonome, come i quadricotteri armati, selezionano ed “eliminano le persone con specifici criteri predeterminati”, senza il bisogno di interventi umani. “Il dispiegamento di tali sistemi sarà praticabile – concretamente se non legalmente – nel giro di qualche anno, non di decenni, e i rischi sono alti”, avvertivano i ricercatori, sottolineando che le armi militari basate sull’intelligenza artificiale “richiedono materiale grezzo economico e facile da reperire, quindi saranno diffuse e le maggiori potenze militari potranno produrle a buon mercato in grandi volumi”.

Il mercato nero, i terroristi, i dittatori, i signori della guerra potrebbero mettere le mani su questa tecnologia, “sporcando il campo” della ricerca e i suoi potenziali benefici a livello sociale.

Dunque ben venga l’intelligenza artificiale se usata per aiutare a risolvere molti problemi urgenti della nostra società – disuguaglianze e povertà, il costo crescente della sanità, l’impatto del riscaldamento globale e per automatizzare alcuni lavori frustranti, ma va fermata se applicata alle armi. L’Onu deve intervenire, subito, senza attendere nuovi appelli o le prime vittime dei robot killer, che potrebbero essere impiegati anche in attacchi terroristici.