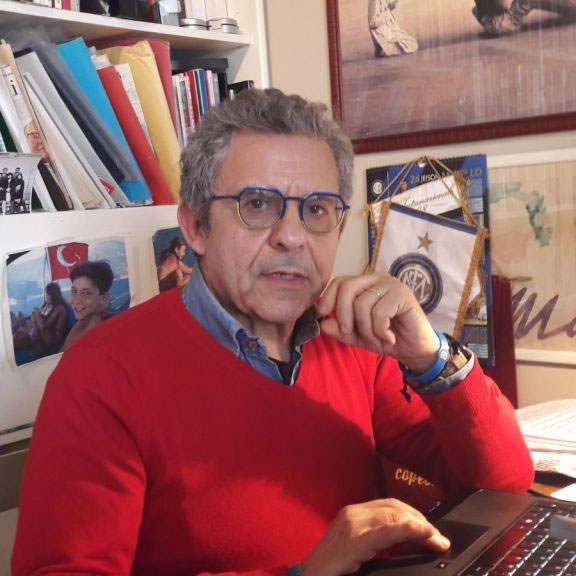

Prosegue la pubblicazione di voci di un glossario per capire la società digitale. Per questo undicesimo fascicolo “Algoritmi” è “La parola chiave per capire come convivere con l’intelligenza artificiale e l’automazione del pensiero” spiegata da Michele Mezza giornalista e docente di Epidemiologia sociale dei dati e degli algoritmi, all’Università Federico II di Napoli. ” interrogarsi su cosa intendiamo per algoritmo significa affrontare il modo in cui l’umanità sta condividendo una nuova forma di convivenza. Una forma che rimane profondamente segnata da contraddizioni sociali che prolungano in modalità diverse, la contrapposizione fra proprietari e subalterni che oggi leggiamo, più aderentemente al contesto digitale, nella contrapposizione fra calcolanti e calcolati. L’algoritmo è un meccanismo, una macchina dice qualcuno, che raccoglie attorno a sé, selezionandone ruoli e funzioni, i proprietari degli apparati di calcolo e gli utenti di questi modelli operativi”.

__________

Un potere definitivo da negoziare permanentemente fa calcolanti e calcolati

Al tempo dell’intelligenza artificiale e dell’automatizzazione del pensiero, con processi di supplenza delle attività intellettuali sempre più programmati e stabili, interrogarsi su cosa intendiamo per algoritmo significa affrontare il modo in cui l’umanità sta condividendo una nuova forma di convivenza. Una forma che rimane profondamente segnata da contraddizioni sociali che prolungano in modalità diverse, la contrapposizione fra proprietari e subalterni che oggi leggiamo, più aderentemente al contesto digitale, nella contrapposizione fra calcolanti e calcolati.

L’algoritmo è un meccanismo, una macchina dice qualcuno, che raccoglie attorno a sé, selezionandone ruoli e funzioni, i proprietari degli apparati di calcolo e gli utenti di questi modelli operativi.

L’intelligenza artificiale allunga su questo dualismo l’ombra di una singolarità del meccanismo che prelude perfino ad una fuoriuscita dalla sovranità del proprietario, ponendo il tema di un’autonomia d’azione della macchina algoritmica.

“sono l’uno che si trasforma in due; sono il due che si trasforma in quattro; sono il quattro che si trasforma in otto. E dopo ciò sono l’uno”

E’ il più antico algoritmo documentato che ci sintetizza una legge numerica di interpretazione del cosmo.

E’ stato ritrovato inciso sul cosiddetto ‘Sarcofago di Petamon’, nell’alto Egitto, e risale a VI° secolo prima di Cristo.

In questa formula si rintracciano tutti gli elementi che oggi ci fanno identificare quella potenza che organizza e ordina la nostra società: il calcolo pianificato, l’ordine numerico, una regola predeterminata, un obbiettivo prefissato.

Un algoritmo, oggi come allora è una sequenza numerica che seguendo una concatenazione di calcoli determina, in una forma lineare di automatizzazione del pensiero, la soluzione di un problema. Nel risolvere il problema, in un modo e in un modo solo, come recitano poi le formule, il dispositivo indirizza e fissa il modo di pensare e dunque di agire.

Dunque potremmo convenire che un algoritmo non è prevalentemente il risultato di un’attività sociale del sapere, ma è uno dei modi sintetici e inappellabili per guidare il pensiero umano da parte di una ristretta élite sociale.

Questa forma di orientamento del pensiero, reso ancora più decentrato e pervasivo dai nuovi dispositivi di Intelligenza Artificiale (AI), è diventata oggi la modalità dominante nel configurare le attività sociali in ogni campo delle relazioni umane. Ed è per questo che diventa indispensabile, per qualsiasi attività intellettuale, tanto più con ambizioni sociali e civiche, comprenderne la struttura e praticarne il controllo. La seconda funzione è imprescindibile dalla prima.

Pertanto ci occupiamo di algoritmi per afferrare l’evoluzione delle relazioni sociali e dei sottostanti rapporti di potere che le determinano.

Come scriveva Karl Marx in quel naturale algoritmo filosofico che sono i Grundrisse, che per architettura editoriale e percorsi cognitivi rappresenta forse una delle anticipazioni più affini agli attuali linguaggi digitali

“In tutte le forme di società è una produzione determinata che assegna rango e influenza a tutte le altre, come del resto anche i suoi rapporti assegnano rango ed influenza a tutti gli altri “[1].

L’algoritmo è una produzione – di senso, di valore, di linguaggio – che assegna rango e influenza a tutte le altre. Oggi aggiungiamo che l’automatizzazione delle attività discrezionali, mediante l’intelligenza artificiale, assegna rango ad ogni intermediazione professionale o culturale.

Torniamo dunque alle origini, ai primi algoritmi egiziani per cogliere come fin dal loro avvento, che coincide con la formazione delle prime piramidi sociali ed istituzionali, queste formule computazionali determinavano poteri, gerarchie e controllo, omologando i comportamenti delle persone in base alle opzioni del calcolo.

L’algoritmo non è onnipotente, ma è sicuramente totalizzante proprio nella sua capacità di intervenire su tutte le variabili del sistema che vengono adattate alle sue possibilità. In questa capacità di ridurre la realtà a sé stesso l’algoritmo, come spiega nel suo saggio sul tema Pedro Domingos, “è definitivo”[2].

Gli algoritmi sono dunque espressioni di calcolo pianificato finalizzate ad ottenere un risultato sociale, automaticamente. La potenza che essi esprimono si esplica proprio nell’applicare alle relazioni sociali il determinismo matematico.

La dittatura del calcolo. Autoritarismo, inaccessibilità e categoricità

Come ci indica Paolo Zellini nel suo saggio La Dittatura del Calcolo[3], gli algoritmi non fanno che estendere le funzioni rituali di controllo e di ripartizione dei numeri in modo che possono diventare inaccessibili, autoritari e categorici.

Autoritarismo, inaccessibilità e categoricità sono le tre dimensioni che nello scorrere dei secoli non si sono mai perse nell’applicazione di queste macchine cognitive.

L’origine risale a molto prima dello stesso sarcofago di Petamon, e coincide con la strutturazione delle élites fin dalla primitiva costituzione della società egiziana, annunciandoci quel nesso indissolubile fra calcolo e potere.

Gli antichi abitanti della valle del Nilo si distaccarono dalle popolazioni vicine in virtù proprio della loro capacità a rendere efficienti i numeri.

Usavano un metodo per eseguire le moltiplicazioni che, di fatto, si basa sulla rappresentazione dei numeri in base 2. Questo metodo è descritto sul papiro di Rhind o papiro di Ahmes, che si stima risalgano alla ventesima dinastia, tra il 1985 e il 1795 prima di Cristo. Il papiro prende il nome dal suo ultimo acquirente, Alexander Henry Rhind che lo donò poi al British Museum di Londra, dove tuttora è conservato.

La capacità di eseguire quel calcolo rese quelle figure sociali titolari della massima capacità di intervenire, sulla natura, riuscendo a decifrarne i meccanismi, e come tali, a poter interpretare il cielo, dando al popolo una religione, e, di conseguenza, un assetto gerarchico fondato sulla casta di sacerdoti.

Quasi quattro millenni più tardi, nel paese che rappresentava quello che l’Egitto era al tempo dello scriba Ahmes, gli Stati Uniti d’America, ossia la massima potenza tecnologica del mondo conosciuto, con un algoritmo, seguendo esattamente gli stessi automatismi computazionali, ha calcolato il processo di formazione delle opinioni politiche, manomettendo, irreversibilmente, il sistema democratico di tutto il pianeta. Cambridge Analytica, il sistema di marketing digitale che ha riconvertito i sondaggi in forme dirette e nominative di manipolazione della coscienza di ogni singolo elettore in occasione delle elezioni presidenziali del 2016 negli USA, non ha fatto altro che tradurre nei levigati e fosforescenti codici del terzo millennio le ambizioni di dominio sui destini umani che coltivavano i primi elaboratori di algoritmi.

Cristopher Wylie, il luciferino talento che elaborò proprio l’algoritmi predittivo che portò Donald Trump alla Casa Bianca così descrive l’operazione:

Se le unità di misura della cultura sono le persone, e queste ultime possono essere quantificate in base ai dati sui social, allora possiamo quantificare la cultura usando Internet, giusto? Una volta quantificata, la possiamo cambiare. Ciò di cui parlava Bannon era molto simile alle ricerche che facevo dedicandomi alla moda. Lui voleva creare un trend, e un trend non è nient’altro che un movimento all’interno di una cultura. Lo definiamo “diffusione a cascata dell’informazione.

L’intima coscienza politica di un individuo che orienta le sue posizioni politiche ma anche di consumo dunque è intercettabile, condizionabile e anche misurabile. Una volta misurata quest’intimità individuale, si possono poi identificare le persone il cui senso comune puoi far spostare progressivamente in una certa direzione. Se ci riesci, allora hai cambiato la cultura[4]

L’algoritmo rende calcolabile, e dunque misurabile le componenti del comportamento umano, dischiudendo ai suoi proprietari la via per accedere direttamente alla nostra coscienza. Si dispiega in questo modo quello che già nel lontano 1959, il premio Nobel Eugene Paul Wigner definiva “l’irragionevole efficacia della matematica nelle scienze naturali”. Questa irragionevole efficacia è prodotta dall’applicazione di un modello di calcolo ad una massa di dati. Proprio la disponibilità di questa massa di dati permette oggi agli algoritmi cognitivi di poter campionare ogni nostra attività, scomponendola in singoli atti e in tipiche azioni decisionali che vengono così memorizzate nel complesso sistema di addestramento dell’intelligenza artificiale.

L’irruzione sulla scena del flusso dei dati deforma e distorce ogni modello di relazione che lega gli esseri umani, dando agli algoritmi una potenza inedita e assolutamente sorprendente perfino per i loro proprietari. Ogni nostra azione che viene impaginata da un sistema digitale, e oggi sono la totalità degli atti che compiamo ormai sia consciamente che inconsciamente, determina una striscia di informazioni sull’intera sfera emotiva e razionale da permettere ai titolari dei sistemi di calcolo automatico di poter azzerare ogni incertezza e azzardo nel modo con cui possono rivolgersi a noi per ottenere un vantaggio.

Nel suo ormai citatissimo saggio Il Capitalismo della Sorveglianza[5], Shoshanna Zuboff compie una vera anatomia dei nuovi sistemi algoritmici, individuando quello che definisce “Il problema dei due testi”.

Analizzando il trasferimento su piattaforme delle nostre informazioni l’autrice del saggio individua in ogni contenuto due testi sovrapposti. Il primo, di cui noi siamo tanto gli autori che i lettori, rivolto al pubblico, con una forma per noi relativamente rassicurante perché di fatto riproduce la secolare esperienza della stampa, con un formato testuale esplicito e vivibile, dove ogni nostro post o commento risulta immediatamente registrabile e condivisibile da un nostro interlocutore.

Se non che, scrive la Zuboff

“Tutto quello che offriamo al primo testo, non importa quanto esso possa essere irrilevante o effimero, diventa un bersaglio per l’estrazione del surplus. Questo surplus riempie le pagine del secondo testo, che è celato Alla nostra vista: una lettura riservata solo per i capitalisti della sorveglianza. In questo secondo testo la nostra esperienza viene costretta a diventare una materia prima da accumulare per fini commerciali di altre persone”.

In questo secondo testo si annida una risorsa preziosissima che sta riclassificando l’economia mondiale ben più di quanto non abbia fatto prima il carbone e poi il petrolio: i big data.

Questa risorsa ridisegna completamente il contesto e l’uso dei bit a cui si riferiva Wheeler nel suo aforismo per cui “tutto è informazione”. In realtà tutto è dati, e persino l’informazione diventa una pratica sociale diffusa e ridistribuita con l’obbiettivo di massimizzare la produzione dei dati.

Siamo dinanzi ad un fenomeno che ingigantisce esattamente tutte le strategie con cui i capitalisti vincenti sono riusciti nel tempo a rendere disponibile per loro e indispensabile per i clienti la merce di cui si erano impossessati: dal cotone alle ferrovie, dall’energia elettrica al petrolio alla pubblicità e alla TV.

Oggi, nonostante gli sforzi delle istituzioni europee e persino i sussulti delle autorità statunitensi che hanno, alla vigilia delle prossime elezioni presidenziali, messo sotto controllo le grandi piattaforme di profilazione, siamo alla deregulation dei big data che passa per una de professionalizzazione dell’informazione in una seducente offerta di nuovo patto sociale che gli stessi capitalisti della sorveglianza, secondo la Zuboff, offrono ad ogni singolo abitante del pianeta: tu avrai la percezione di esercitare più potere di incidenza nella tua comunità e di trasmissione attiva di comunicazione a fronte di un flusso inesauribile di dati che fornirai e che ci permetterai di poter combinare all’infinito.

In questo nuovo patto di cittadinanza i giornalisti sono le vittime sacrificali, come in generale tutti i mediatori: i docenti, i medici, i sacerdoti, gli avvocati, i politici.

Del resto basta guardare i numeri per intuire che l’ondata che ci sta sommergendo non può non avere alle spalle una forte ragione di interessi che la muove: nel 1986 solo 1 per cento di tutta l’informazione del mondo era digitalizzata; il 25 per cento nel 2000, nel 2013 eravamo già al 98 per cento[6].

Oggi siamo arrivati alla constatazione che tutto e sempre è informazione.

Gli algoritmi sono, dunque, il principio che divide il mondo in base all’accesso proprietario ai sistemi di calcolo. Ma sono anche un principio eversivo, che stravolge lo stesso mercato capitalista. Infatti rendere visibile i meccanismi del mercato, e specificatamente le relazioni fra domanda ed offerta, come accade a chi è in grado di raccogliere ed analizzare i big data, con dispositivi di calcolo sofisticato, significa stravolgere anche le gerarchie fra le imprese e i capitalisti stessi.

Friedrich von Hayek, il capostipite degli economisti liberisti, che ha dato una base culturale e una ragione d’essere all’autorità del mercato, rassicurava i ceti medi americani sull’evoluzione del capitalismo proprietario spiegando che

“l’economia moderna ci spiega come un tale ordine esteso costituisca un processo di raccolta delle informazioni che nessun planing agency e soprattutto nessun individuo può conoscere, possedere o controllare nel suo complesso”[7].

L’offensiva degli Stati sovrani

Oggi non è più così. Un planing agency, ma anche solo un individuo più rendere visibile la mano del mercato, facendo cadere l’unica ragione che potrebbe dare una giustificazione alla prevaricazione della proprietà sul consumo, che è appunto l’alea di rischio sull’investimento.

Non a caso lo scenario che vedeva un trionfo di valori e di immagini dei principi rinascimentali della Silicon Valley – da Google a Amazon a Facebook – si è largamente incrinato anche per un’offensiva degli Stati sovrani.

In particolare da Cina e Russia è venuta avanti quella che The Economist ha chiamato Techlash, ossia una nazionalizzazione dei sistemi digitali. Si è configurata in alternativa ai monopoli privati americani una forma di algoritmi-nazione, dove l’autorità dello Stato si affermava in base al controllo dei sistemi e dei circuiti computazionali. E’ in prima persona il capo di stato maggiore russo, Valerij Gerasimov, che si contrappone alla strategia delle corporation digitali americane, e ripensa in termini reticolari una nuova teoria di guerra asimmetrica, dove non è più la leggerezza dei combattenti, come sosteneva qualche anno fa l’ex capo del Pentagono di George Bush Donald Rumsfeld, quanto la contaminazione dei linguaggi e le determinazione dei profili sociali ad imporsi come vincenti.

La guerra in Ucraina che in un mio testo ho definito Netwar[8] rende gli algoritmi strutture portanti dei nuovi arsenali, non più in quanto sistemi di automatizzazione delle armi, quanto proprio come meccanismi di creazione e diffusione delle informazioni.

Nel 2013, dopo le rivolte in Ucraina e Bielorussa, inequivocabilmente fomentate da social network atlantici il comandante delle armate russe pubblica un saggio che fissa i nuovi paletti della strategia militare del Cremlino:

«Nel 21esimo secolo abbiamo visto nascere la tendenza a un confine sempre più sfocato tra la guerra e la pace: le guerre non vengono più dichiarate e, una volta cominciate, procedono secondo un modello sconosciuto».

Le guerre non dichiarate sono appunto i conflitti degli algoritmi. Siamo ad un tornante che dalle ormai vetuste teorie pacifiste anti nucleari ci troviamo dinanzi gli arsenali dei bot e dei malware che deformano i processi di formazione dell’opinione pubblica nazionale.

Qualcosa sembra mutare con la strategia in materia di Intelligenza artificiale che ha assunto la Comunità Europea.

Una scelta che vede impegnare ingentissime risorse, 200 miliardi in 10 anni, il doppio di quanto spende la Cina e quasi gli investimenti americani, per raggiungere la piena competitività sul mercato tecnologico, una competitività però, spiegano i dirigenti europei che non deve semplicemente duplicare modelli e valori dei due contendenti principali ma realizzare in Europa un’area in cui gli algoritmi siano trasparenti, condivisibili e negoziabili, per arrivare proprio grazie a questi fattori ad incrementare la capacità di innovazione che ultimamente si è rallentata proprio per le ipoteche dei monopoli privati americani e statali cinesi.

Un campo di conflitto sociale dove si consolidano visioni senso e modelli di comando

La scelta europea dà sostanza e massa critica ad una visione che oggi appare ancora marginale e minoritaria, che in qualche modo troviamo espressa in maniera organica nell’enciclica Laudato Sii di Papa Francesco che parla della scienza e tecnica come beni comuni.

L’evoluzione dei sistemi automatizzati, basati sulla calcolabilità dell’intelligenza, definizione più appropriata per centrare quanto sta accadendo rispetto alla generica ed immaginifica idea di Intelligenza artificiale, mostra come gli algoritmi siano un campo di conflitto sociale, dove si consolidano visioni, senso e soprattutto modelli di comando.

Gli enti non sono altro che potenza – scriveva Platone ne Il Sofista – introducendo nella speculazione filosofica l’idea di un’attività meccanica che avrebbe affiancato gli uomini nella produzione di valore. Un’idea che ha cominciato a ruminare negli anfratti del sapere, spingendo sempre più avanti il macchinismo, fino al grande salto che si compì in quella straordinaria stagione del sapere umano che fu il Diciassettesimo secolo, l’era dei grandi scienziati, da Galileo a Cartesio, a Newton a Pascal e Leibniz. Ognuno di questi concorre a rendere completo e organico un sistema di calcolo che permette di risolvere un’equazione algebrica in modo da rendere l’algoritmo non solo definito ma efficiente, capace ciò è di affiancare, sostenere e gradualmente sostituire l’azione umana.

Con quella svolta si fa largo anche una visione del mondo policentrica che Giordano Bruno, il filosofo nolano che comincia a computare il linguaggio ipertestuale mediante le sue Opere magiche sintetizzerà nella formula:

“nell’infinito spazio possiamo definire centro nessun punto, o tutti i punti: per questo lo definiamo sfera il cui centro è ovunque”.

Il calcolo si fa orizzontale, e dopo due millenni di sostegno a geometrie verticali dei poteri apre la strada ad una visione policentrica, che avviare quella lenta inizialmente ed ora frenetica, marcia verso la disintermediazione.

La potenza di calcolo e la configurazione a rete introducono i due poli di un conflitto cosmico che attraversa tutta la modernità, accelerando proporzionalmente alla domanda sociale di connessione reticolare.

L’illuminismo rivoluzionario francese, preceduto dall’affermazione della moltitudine borghese americana che fonda uno Stato sul diritto alla proprietà e alla felicità, ci conduce nell’Ottocento all’automatizzazione della fatica, mediante il vapore e il carbone prima e il fordismo poi.

Le fabbriche sono algoritmi meccanici che combinano sequenza – linea di calcolo con sequenza – linea manifatturiera. Proprio la contrapposizione di queste due linee rette che si fronteggiano ma non si incontrano determina il primo grande patto sociale contemporaneo fra capitale e lavoro che darà corpo alla civiltà dei diritti e della democrazia. Ma l’attrito del conflitto sociale inevitabilmente prefigura possibili rovesciamenti del quadro sia economico sia istituzionale come la Rivoluzione d’Ottobre fece intendere.

Entra così in incubazione una nuova marca di capitalismo che cerca di ridimensionare la sua controparte naturale che è il lavoro manifatturiero. Inizialmente si mira a ridimensionare la potenza di interdizione delle masse, creando forme individuali di intervento sociale.

L’algoritmo diventa comunicazione, prima la radio e poi la televisione, e tramite la pubblicità che comincia a finanziare le ricerche di mercato e le elaborazioni dei primi dati, diventa consumo individuale.

Si creano i presupposti di quello che John Maynard Keynes, con una delle sue più geniali e incomprese intuizioni, anticipò fin dalla metà degli anni Trenta, in una sua lettera a George Bernard Show, come la trasformazione dell’economia da industriale a terziaria. Un cambio allora nemmeno percepito dai suoi colleghi economisti che lui così sarcasticamente descrive:

“come geometri euclidei in un mondo non euclideo i quali scoprendo che nell’esperienza concreta due rette apparentemente parallele spesso si incontrano, sgridano aspramente le linee stesse per la loro incapacità di andare diritte come se fosse l’unico rimedio alle disastrose collisioni che si verificano un po’ ovunque. Mentre l’unico rimedio possibile è gettar via gli assiomi delle parallele e mettersi a lavorare su una geometria non euclidea”.

Nel dopoguerra negli Stati Uniti d’America, sull’onda degli algoritmi nucleari che avevano dato il primato alle due super potenze, cominciano a proliferare gli economisti non euclidei. La potenza di calcolo diventa non solo industrialmente efficiente, come iniziò a fare con Newton, ma si rivela socialmente performante. In questa direzione svolta con decisione e aggressività il capitalismo americano. Fondamentale in questo fu il celebre saggio di Vannevar Bush, nel luglio del 1945 As we may think[9] che, rispondendo al quesito del Dipartimento di Stato su come si potesse battere il futuro avversario sovietico, individuò la risposta nel superamento del lavoro di fabbrica come matrice del valore e la sua sostituzione con il sapere. Si innestò quel processo di ingegneria sociale che gradualmente trasformò gli sfruttati in consumatori, e poi in competitori, comunque sempre in calcolati. Arriviamo al 1968, anzi al 1964 americano, all’inizio di quella straordinaria stagione dei giovani che diventano soggetto politico, e che aprì la porta di un nuovo protagonismo individuale, attraverso la programmazione del codice. Dal Free speech di Mario Savio a Berkeley del 1964, si arriva in pochi mesi al Free software di Richard Stalman a San Francisco. Gli algoritmi diventano quella che Adriano Olivetti in uno storico discorso al Presidente della Repubblica del tempo, Giovanni Gronchi, definì come “tecnologia di libertà”[10]. Pochi in Europa ragionarono sul come mai negli stessi posti, le stesse persone, con le stesse culture e linguaggi, in pochi mesi, passarono dalla mobilitazione dei diritti civili alla pratica degli algoritmi per liberarsi dalle costrizioni autoritarie. Nel cuore degli anni Settanta, mentre in Italia si marciava per il potere agli operai, nella costa occidentale si apriva il primo conflitto moderno per il controllo sociale del sapere computazionale, esattamente come veniva descritto da Karl Marx che scriveva:

”la potenza delle macchine non sta in alcun rapporto con il tempo di lavoro immediato che costa la loro produzione, ma dipende piuttosto dallo stato generale della scienza e dal progresso della tecnologia, o dall’applicazione di questa scienza alla produzione”

Il pretesto per quella lotta di classe digitale era il copyright del codice, dei programmi che facevano girare i primi personal computer. Una battaglia che viene perduta dall’ala più libertaria del movimento dei programmatori, lasciata sola e priva di ogni sponda dalla sinistra europea.

Ma rimane forte, comunque l’istinto di autonomia e sovranità, che spinge, periodicamente in avanti i confini della pratica sociale comunitaria in rete.

L’evoluzione del capitalismo da macchina del plusvalore a sistema di trasformazione in attività di mercato

Come constata nel suo saggio Post capitalismo Paul Mason[11], uno dei più innovativi e combattivi economisti della sinistra inglese, l’evoluzione del capitalismo infatti non ha collassato, sobbalzato, scartato, così come era nel novero delle previsioni delle teorie socialiste e comuniste, piuttosto ha seguito, quasi pedissequamente, le forme indicate proprio dalla bussola marxista, in particolare nel suo decisivo passaggio da pura macchina del plusvalore operaio a sistema che “trasforma attività non di mercato in attività di mercato”.

Arriviamo così ai nostri giorni dopo aver compreso da quale mondo e per quali interessi gli algoritmi diventano egemoni nella nostra società.

Arriviamo appunto al capitalismo della sorveglianza di Shoshanna Zuboff che abbiamo già saccheggiato[12]. Siamo nel gorgo di quel sistema che tramite le forme più auto predittive degli algoritmi, alimentati da messe poderose di dati, può oggi pianificare i nostri comportamenti. Il saggio della Zuboff arriva alla conclusione, riferendosi ai grandi gruppi monopolistici sia pubblici sia privati: sanno troppo per essere liberi.

Ma il tema va al di là della rigorosa applicazione di norme anti-trust a sistemi di calcolo.

Riguarda proprio la natura del potere che applica il determinismo numerico alla morfologia sociale. E’ proprio la semantica della combinazione matematica che contiene un senso eversivo e totalitario.

Un senso che può essere neutralizzato, e rovesciato nel suo contrario solo da una nuova pratica conflittuale che assume la concatenazione pianificata di calcoli come base per una permanente negoziazione.

Un animale sempre in movimento

L’algoritmo è infatti un ghepardo, non un elefante, un animale sempre in movimento, che si sposta freneticamente.

Google nel 2019 ha cambiato per ben 6.472 volte il suo software di base. Come si fa a negoziare con un flusso che scorre? Con un altro flusso di pari velocità.

Un algoritmo è infatti negoziabile solo con un altro algoritmo, con un’altra piattaforma.

E’ quello che stiamo imparando dalle prime esperienze che nascono nelle città, come Londra, Copenaghen, ma anche Milano e Napoli, dove si sta discutendo di piano regolatore delle intelligenze e della connettività.

L’avvento del 5G, con la sua grande capacità di trasporto dei segnali pone infatti il tema di come e quando la città viene inclusa in questo standard che non è rigido e monolitico ma configurabile e liquido, che prende la forma del contenitore, che assume la potenza dell’utente.

Quali priorità e quali forme automatiche sono necessarie in una zona ospedaliera o in un distretto produttivo o in un’area espositiva?

Ma ancora di più, nella sanità, o nella giustizia gli algoritmi che stanno automatizzando professioni che assicurano servizi di cittadinanza come possono essere campionati e verificati?

Come può essere resa visibile e trasparente la dotazione etica e il corredo delle procedure cognitive?

Si sta aprendo una nuova marca delle forme di socializzazione della scienza e delle tecnologie, in cui proprio la fase più delicata della ricerca e della prototipazione deve essere vincolata a procedure di controllo pubblico.

Una strategia che, in una economia non euclidea appunto, non sono concessioni a pressioni ideologiche o politiche ma requisiti essenziali per rendere gli automatismi algoritmici affidabili, sicuri ed efficienti. Per questo ancora Mason nel testo che abbiamo citato può affermare che

“ci sono sempre più prove che le tecnologie informatiche, invece di creare una forma di capitalismo nuova e stabile, stanno dissolvendo il capitalismo: corrodono i meccanismi di mercato, erodono i diritti di proprietà e distruggono la vecchia relazione fra salari, lavoro, profitto.”

Questa volta siamo noi, popolo di cittadini produttori e creativi che siamo a casa nostra.

[1]Karl Marx, Grundrisse der Kritik der politischen Ökonomie (1957-1858). Traduzione italiana: Grundrisse, Lineamenti fondamentali della critica dell’economia politica, Milano, PGreco editore, 2012. Volume 1: XXXII-762 p. Volume 2. XIII, 764-1364 [Il passo è tratto dal Volume 1 alla p. 32].

[2]Pedro Domingos, L’algoritmo definitivo. La macchina che impara da sola e il futuro del nostro mondo, Torino, Bollati -Boringhieri, 2016, 354 p.

[3] Paolo Zellini, La Dittatura del Calcolo, Milano, Adelphi editore, 2018, 186 p.

[4] “Scandalo Cambridge Analytica. Intervista a Christopher Wylie”, Vogue Italia, 9 maggio 2018. Cf.

[5] Shoshana Zuboff, The Age of Surveillance Capitalism. The Fight for a human Future at the new Frontier of Power, Campus,2018. Traduzione italiana: Il capitalismo della sorveglianza. Il futuro dell’umanità nell’era dei nuovi poteri, Roma, Luiss University Press, 2019, 622 p.

[6] Martin Hilbert, “Toward Syntesis of cognitive bases: How Noisy information processing can Bias human decision making”, Psycological Bulletin, CXXXVIII (2), marzo 2012, pp. 211-237. Cf. https://pubmed.ncbi.nlm.nih.gov/22122235/.

[7] Friedrich von Hayek, The fatal conceit. The errors of socialism, edited by W.W. Bartley III, Chicago, The University of Chicago Press, 1991, XIII-180 p. Traduzione italiana di Fabrizio Mattesini: La presunzione fatale. Gli errori del socialismo, edizione italiana a cura di Dario Antiseri, Milano, Rusconi Libri, 1997, 264 p.

[8] Michele Mezza – Net-War. Ucraina: come il giornalismo st cambiando la guerra, Con un post scritto di Pierluigi Iezzi, Roma, Donzelli, 2022, VI-226 p. Vedine la recensione di Stefano Rolando, “Net-War. Il digitale come algoritmo e come arma”, Democrazia futura, II (8), ottobre-dicembre 2022, pp. 1379-1384

[9] Vannevar Bush, “As we may think”, The Atlantic Monthly, July 1945. Cf. As We May Think, Vannevar Bush.

[10] Michele Mezza, Avevamo la Luna. L’Italia del miracolo sfiorato, vista cinquant’anni dopo da Giovanni XXIII a Francesco, da Olivetti a Marchionne, da Moro a Grillo, Roma, Donzelli editore, 2012, X-350 p.

[11] Paul Mason, PostCapitalism. A Guide to our Future, London, Allan Lane, 2015, 368 p. Traduzione italiana di Fabio Galimberti: Post capitalismo. Una guida al nostro futuro, Milano, Il Saggiatore, 2016, 382 p.

[12] All’interno del Focus di approfondimento “Big data e capitalismo della sorveglianza” si veda Michele Mezza, “Senza Stato e senza rischio”, Democrazia futura, numero zero, ottobre 2020, pp. 59-67.