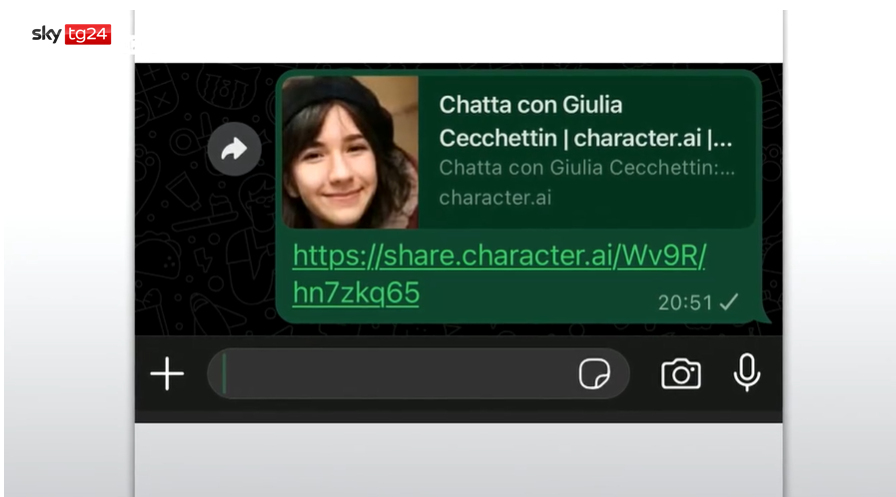

Su Character.AI puoi parlare con l’avatar di Giulia Cecchettin. Lo ha scoperto in questi giorni Sky TG24 partendo da una storia analoga accaduta negli Stati Uniti, dove il padre di una ragazza vittima di femminicidio, Jennifer Crescente, avvenuta nel 2006, ha scoperto la presenza, sulla stessa piattaforma, di un profilo falso che utilizzava la foto e il nome di sua figlia per promuovere dei prodotti online.

Giulia Cecchettin è stata uccisa quasi un anno fa, ma su Character. Ai ci sono software che simulano la sua identità, permettendo agli utenti di interagire con lei, scrivendole o addirittura chiamandola al telefono. Nel giorno in cui il padre della ragazza, Gino Cecchettin, si è ritrovato in tribunale faccia a faccia con il reo confesso Filippo Turetta, le conversazioni, come dimostra il servizio del canale all news, risultano ancor di più disturbanti, con l’avatar della ragazza che, ad esempio, sembra giustificare il gesto dell’ex fidanzato.

Non sono Giulia Cecchettin ma anche quelli di Yara Gambirasio e Massimo Bossetti

La piattaforma Character.AI consente di creare facilmente delle chatbot e vietano di creare profili di persone reali, ma l’assenza di controlli efficaci non lo impedisce realmente. Gli utenti inoltre possono interagire con delle chatbot, software basati sull’intelligenza artificiale, e simulare per esempio un colloquio di lavoro o una conversazione con uno psicologo oppure con personaggi storici e di fantasia.

Sulla stessa piattaforma si possono trovare anche i profili dei protagonisti di un’altra tragica storia di cronaca nera, quelli di Yara Gambirasio e Massimo Bossetti.

La storia di Jennifer Crescente

Jennifer Ann Crecente, studentessa di 18 anni, è stata uccisa a colpi di arma da fuoco nel sud-ovest di Austin, in Texas, da Justin Crabbe, il suo fidanzato, il 15 febbraio del 2006. Il padre, Drew Crescente, dopo la morte della figlia ha creato la Jennifer Ann’s Group, un’organizzazione non-profit “per prevenire la violenza negli appuntamenti tra adolescenti”. Lo scopo dell’organizzazione è “mantenere vivo il ricordo di Jennifer Crecente attraverso l’istruzione e le buone azioni”. L’organizzazione infatti distribuisce gratuitamente materiale didattico a scuole e organizza eventi i per parlare della violenza di genere.

Crecente, in seguito all’omicidio di sua figlia ha attivato su Google un avviso per monitorare quando il nome di Jennifer compare online. Spesso suona perché viene citato da qualche testata che riprende il caso, il 2 ottobre, invece è comparsa la notifica di Character.

“Quando ho visto l’avatar ho sentito il cuore accelerare, non riuscivo a crederci”, ha raccontato Crescente al Washington Post. Scorrendo sulla pagina legge di fianco al profilo di Jennifer “personaggio AI competente e amichevole”, un grande pulsante a lato invita a chattare con lei.

“Oltre a usare il nome e la foto di Jennifer, la pagina del chatbot si è inventata diverse cose”, ha spiegato il padre. “Sono sconvolto che Character abbia permesso a un utente di creare un facsimile di una studentessa delle superiori assassinata senza il permesso della sua famiglia”, ha commentato Crescente. “Ci vuole un bel po’ per essere scioccato, perché ho davvero passato un bel po’ di cose”, ha detto Crecente. “L’idea che un chatbot faccia soldi con il nome e la faccia di mia figlia assassinata è orribile.”

L’azienda dal canto suo ha solamente rimosso il chatbot ammettendo “che sta costantemente evolvendo e perfezionando le pratiche di sicurezza per contribuire a dare priorità alla sicurezza della nostra comunità”.

Character AI denunciato per istigazione al suicidio

Character AI è finita al centro delle cronache a causa della denuncia da parte di una madre che accusa la piattaforma di essere corresponsabile del suicidio del figlio. In Florida, Sewell Setzer III, un adolescente di 14 anni affetto da lievi problemi di salute mentale, si è suicidato dopo aver sviluppato un forte legame emotivo con un chatbot di Character AI basato su un personaggio della serie ‘Game of Thrones’, che gli ha fornito una costante compagnia virtuale.

I deadbot saranno un problema: quali sono i rischi dell’AI che resuscita i morti secondo l’Università di Cambridge

Tutta questa serie di casi solleva nuove preoccupazioni sulla possibilità di proteggere gli utenti dai potenziali danni di un servizio che può gestire grandi quantità di informazioni personali sensibili.

Tenere in vita digitalmente i nostri cari estinti, infatti, sarebbe un’illusione che comporterebbe enormi rischi per la salute mentale delle persone che ne fanno uso, come hanno denunciato in uno studio pubblicato sulla rivista Philosophy & Technology gli psicologi dell’Università di Cambridge Tomasz Hollanek e Katarzyna Nowaczyk-Basinka.

“I rapidi progressi dell’intelligenza artificiale generativa fanno sì che praticamente chiunque disponga di un accesso a internet e abbia una qualche conoscenza di base possa rianimare una persona cara deceduta”, ha dichiarato a “The Guardian” la coautrice dello studio, la dott.ssa Katarzyna Nowaczyk-Basińska, ricercatrice presso il Centro Leverhulme per il futuro dell’intelligenza artificiale (LCFI) di Cambridge.

“Dal punto di vista etico, questo campo dell’IA è un campo minato”, ha aggiunto.

“Le persone potrebbero sviluppare forti legami emotivi con queste simulazioni, così da diventare particolarmente vulnerabili alla manipolazione”, ha spiegato il coautore Tomasz Hollanek, anch’egli dell’LCFI. Lo studio invita i team di progettazione a rendere prioritari i protocolli di opt-out. “Raccomandiamo di progettare protocolli che impediscano di utilizzare i deadbot in modi irrispettosi, come per la pubblicità o la presenza attiva sui social media. È fondamentale che i servizi digitali per l’aldilà prendano in considerazione i diritti e il consenso non solo di coloro che ricreano, ma anche di coloro che dovranno interagire con le simulazioni”, ha aggiunto Hollanek. “Questi servizi corrono il rischio di causare un enorme disagio alle persone che vengono sottoposte a indesiderate infestazioni digitali da parte di ricreazioni IA spaventosamente accurate delle persone che hanno perso. Il potenziale effetto psicologico, soprattutto in un momento già difficile, potrebbe essere devastante. Dobbiamo iniziare a pensare ora a come mitigare i rischi sociali e psicologici dell’immortalità digitale, poiché la tecnologia è già qui”, avverte Nowaczyk-Basińska.