Nelle loro presentazioni Microsoft, OpenAI, Google ecc… descrivono solo la potenza e le notevoli ed immaginabili potenzialità dei loro sistemi di intelligenza artificiale generativa. Ma quanto sono trasparenti i loro modelli fondativi, come chatGPT, Bard o altri?

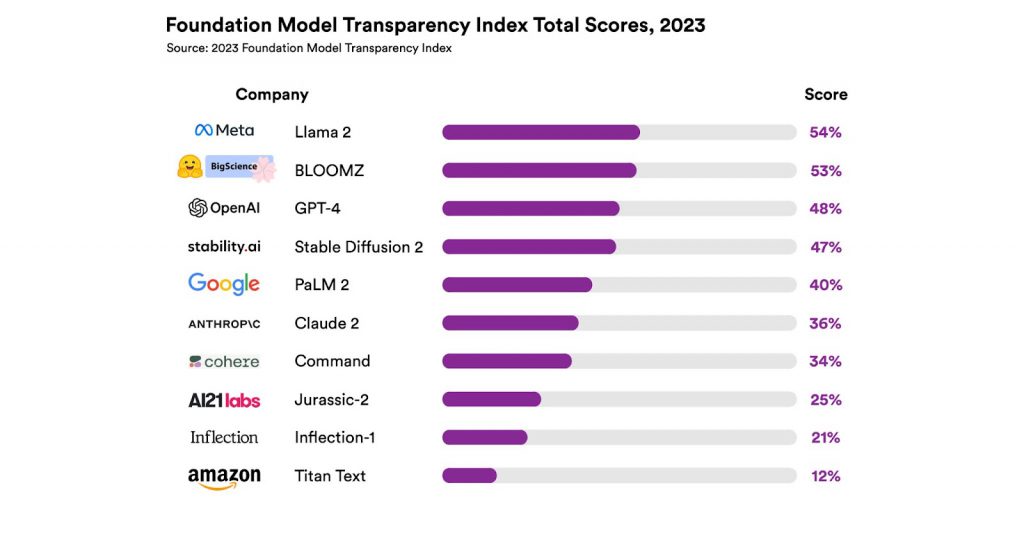

Gli studiosi del Center for Research on Foundation Models della Stanford University hanno sviluppato il Foundation Model Transparency Index (FMTI), che valuta le aziende e i loro modelli su 100 aspetti di trasparenza che vanno dalla costruzione del modello all’utilizzo a valle. Delle 10 aziende valutate, Meta ha ottenuto il punteggio più alto, 54%, con Llma 2.

Al secondo posto c’è BLOOMZ, della francese BigScience. Solo al terzo posto OpenAI con l’ultima versione di ChatGPT.

La trasparenza dell’AI è fondamentale quanto sapere le potenzialità dei sistemi di IA generativa, perché in questo modo è possibile sapere quali tipi di dati vengono utilizzati per addestrare gli algoritmi. Per esempio, se sono dati raccolti in modo lecito o con la raccolta massiva (webscraping) di dati personali senza consenso degli interessati. La tanto decantata algoretica si concretizza anche così, con la trasparenza dei dati usati per l’AI.