Citando uno dei claim di OpenAI, l’intelligenza artificiale dovrebbe essere utilizzata per un bene più ampio per la società. Finora, l’unico bene che vediamo è quello delle aziende che vendono i loro sistemi a scopo di produttività ma c’è un certo fermento nel voler capire come l’AI possa davvero supportare l’evoluzione dell’uomo, soprattutto nel merito della riduzione delle disuguaglianze. Solo qualche giorno fa, citavano il Global Index sull’AI responsabile, a dimostrazione di come l’Italia non sia così indieto nello sviluppo di un ecosistema consapevole.

Oggi tocca al report “AI for Impact: The Role of AI in Social Innovation“, voluto dal World Economic Forum per restituire un panorama contestuale dell’implementazione dell’AI in segmenti come l’impatto sociale, la geografia di genere e lo sviluppo di benessere globale. Il white paper, che si scarica da qui, è risultato del lavoro del Presidio Framework dell’AI Governance Alliance (AIGA) del World Economic Forum. Il rapporto, sviluppato in collaborazione con Microsoft ed EY, si basa su approfondimenti raccolti da oltre 300 casi di studio sull’innovazione sociale e interviste a esperti e introduce PRISM (Principles for Responsible Implementation, Scale and Management of AI), una guida all’adozione progressiva e responsabile dell’AI per un impatto positivo, che evidenzia anche i rischi e le carenze da affrontare per un’implementazione equa.

Limiti geografici

Partendo da percorsi e casi studio, l’obiettivo è mostrare esempi reali di innovazione sociale con l’AI, condividendo peraltro una roadmap da seguire per integrare e implementare l’intelligenza artificiale internamente. Questa serie di report è il risultato del flusso di lavoro AI for Social Innovation della Global Alliance for Social Entrepreneurship, che mira ad aumentare la consapevolezza e a promuovere l’adozione etica dell’intelligenza artificiale da parte degli innovatori sociali e delle imprese di impatto.

Oltre la metà (54%) degli innovatori sociali sta attualmente sfruttando l’intelligenza artificiale per migliorare prodotti o servizi di base e quasi il 30% la sta utilizzando per sviluppare soluzioni completamente nuove. Tuttavia, secondo il nuovo rapporto, ci sono lacune critiche che ne ostacolano un’adozione più ampia.

Solo il 13% delle iniziative si concentra su strumenti educativi, principalmente nel Nord del mondo. Persistono disparità di genere, con solo il 25% delle imprese sociali guidate da donne utilizza l’AI rispetto alla metà del settore in generale. Sono emerse anche sfide e di equità. Ad esempio, la maggior parte dei modelli disponibili in commercio è addestrata su dati provenienti da Paesi ad alto reddito, fornendo risultati risultati inferiori per i Paesi a basso e medio reddito.

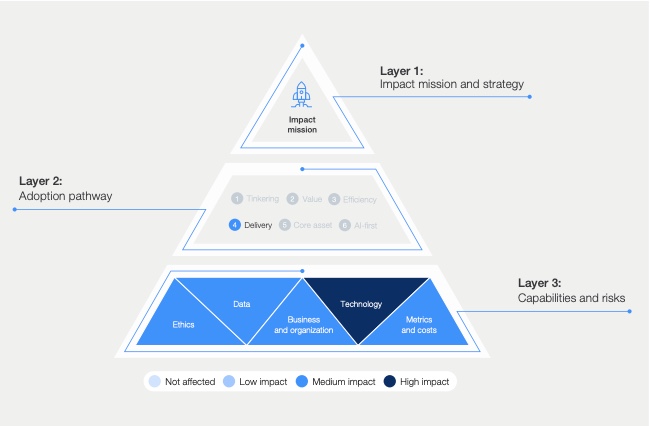

Forma piramidale

L’organizzazione immagina il processo di implementazione dell’AI come una piramide. Alla base ci sono capacità e rischi, nel mezzo i percorsi di adozione mentre, in cima, gli impatti e le strategie. “Considerare le capacità e i rischi dell’etica garantisce che i sistemi di AI siano intelligenti ed equi allo stesso tempo” spiegano gli autori dello studio. “Poiché gli innovatori sociali lavorano spesso con gruppi vulnerabili ed emarginati, questa è una delle considerazioni chiave.

La natura enigmatica del processo decisionale dell’intelligenza artificiale è spesso paragonata a una “scatola nera” in cui gli input e gli output sono e le uscite sono visibili, ma l’elaborazione rimane opaca. Per le organizzazioni che si dedicano all’impatto sociale, scardinare gli strati di questa scatola nera può essere imperativo. Il processo decisionale dell’AI, soprattutto in sistemi complessi come l’analisi predittiva e i motori di raccomandazione, dovrebbe essere chiaro ogni volta che è possibile”.

La sicurezza dei dati

Altro aspetto essenziale riguarda le tecniche di anonimizzazione, utilizzate per evitare che i dati personali siano riconducibili alle persone. Ciò è particolarmente importante per i set di dati utilizzati per l’addestramento dell’intelligenza artificiale, dove la rimozione degli identificatori può contribuire a proteggere la privacy, consentendo al contempo di ottenere informazioni preziose. È importante notare che per identificare una persona è necessario un numero sorprendentemente basso di dati. In un’indagine storica, la ricercatrice del MIT Latanya Sweeney ha dimostrato che l’87% dei cittadini statunitensi può essere identificato in modo univoco utilizzando solo il sesso, il codice postale e la data di nascita – informazioni prontamente disponibili nei dati sanitari. La privacy-by-design cerca di affrontare questi problemi integrando la sicurezza nel processo di sviluppo di nuovi prodotti, sistemi o processi.

Caso studio

SAS Brasil è in procinto di sviluppare uno strumento diagnostico di intelligenza artificiale pensato per prevedere il rischio di cancro al collo dell’utero e accelerarne la diagnosi nelle comunità locali in Brasile. La priorità è quella di affrontare le implicazioni etiche delle applicazioni dell’IA nell’assistenza sanitaria e per questo SAS ha costituito un quadro etico interno con i suoi partner per per guidare lo sviluppo dello strumento. Inoltre, ha voluto affrontare una sfida importante nella distorsione dei dati, dal momento che le serie di dati sono per lo più raccolte da pazienti malati del Nord del mondo, con pochi riferimenti per addestrare l’intelligenza artificiale a livello globale.

Il ruolo degli innovatori

Gli innovatori sociali stanno guidando la rivoluzione dell’IA, in settori come l’assistenza sanitaria, l’istruzione e la conservazione dell’ambiente per aumentare in modo significativo il loro impatto su sfide sociali complesse. Il loro approccio, delineato nel PRISM Framework, stabilisce uno standard per l’integrazione etica dell’IA in tutti i settori, sottolineando l’equilibrio tra preparazione organizzativa, considerazioni etiche e potenziali benefici. Questi esempi dimostrano che la portata dell’AI può estendersi al di là degli usi commerciali, migliorando il modo in cui le organizzazioni affrontano i problemi della società quando sono allineate con una chiara missione sociale. Il Quadro PRISM cattura queste pratiche, offrendo un approccio iterativo all’implementazione dell’AI in modo che la tecnologia si adatti all’uomo e alle sue sfide, e non viceversa.