AI Act, si parte

Entrata in vigore dal 1° agosto, da oggi 2 agosto inizia l’applicazione graduale della legge europea sull’intelligenza artificiale (AI Act), con lo scopo generale di promuovere lo sviluppo e la diffusione responsabili di questa tecnologia così importante in tutta l’Unione europea (Ue).

SI completa il percorso il legislativo (dall’iter di approvazione al periodo di vigenza sulla Gazzetta Ufficiale) dell’AI Act, che ha consentito l’integrazione del Regolamento nell’ordinamento giuridico dell’Unione, e inizia l’ultimo miglio, se così possiamo dire, fondamentale per gli Stati membri, per adempiere agli obblighi preliminari, indispensabili per arrivare alla piena applicazione della legge.

Si dispone così di un quadro normativo normativo uniforme per tutti gli stati membri, che consente di affrontare i potenziali rischi per la salute, la sicurezza e i diritti fondamentali dei cittadini, fornendo agli sviluppatori e agli operatori requisiti e obblighi chiari per quanto riguarda gli usi specifici dell’AI, riducendo nel contempo gli oneri amministrativi e finanziari per le imprese.

Come ha spiegato Margrethe Vestager, vicepresidente esecutiva per Un’Europa pronta per l’era digitale: “L’approccio europeo alla tecnologia pone al primo posto le persone e garantisce che i diritti di tutti siano preservati”.

Il percorso verso la piena applicazione nel 2026

Ogni Paese europeo dovrà designare e comunicare a Bruxelles, entro il 2 agosto 2025, l’Autorità nazionale competente per il monitoraggio dell’applicazione del regolamento e incaricata di tenere i contatti con l’Ufficio AI della Commissione europea, che invece avrà il compito di supervisionare in maniera omogenea l’utilizzo della legge nell’intero territorio dell’Ue.

Un’applicazione graduale, quindi, che invece raggiungerà i pieni livelli operativi solo tra due anni, dal 2 agosto 2026.

Entro sei mesi, a febbraio del 2025, però, le regole più severe saranno attivate per quel che riguarda i sistemi più a rischio. Le regole per l’AI generativa scatteranno dall’agosto 2025.

Per affrontare senza problemi questo lungo periodo di transizione, la Commissione ha varato il patto per l’IA, in cui si invitano gli sviluppatori di AI ad adottare volontariamente gli obblighi fondamentali della legge prima delle scadenze legali.

Un approccio basato sul rischio

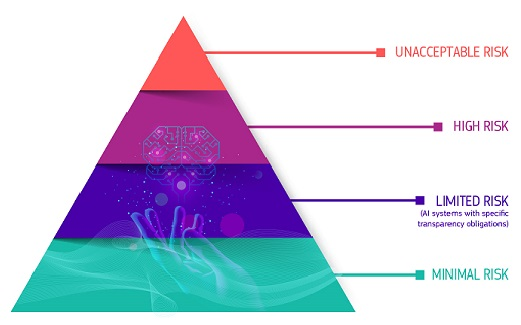

La legge sull’IA introduce una definizione lungimirante di IA, basata su un approccio basato sulla sicurezza dei prodotti e sul rischio nell’UE. Si parla di: rischio minimo, rischio specifico, rischio elevato, rischio inaccettabile.

“Con l’entrata in vigore della legge sull’IA, la democrazia europea ha fornito un quadro efficace, proporzionato e al primo posto a livello mondiale per l’IA, affrontando i rischi e fungendo da piattaforma per le start-up europee“, ha avuto modo di commentare Thierry Breton, commissario per il Mercato interno.

A integrazione di tale approccio, la legge introduce ulteriori norme per i cosiddetti modelli di AI per finalità generali (GPAI), modelli avanzati progettati per svolgere un’ampia gamma di compiti, come la generazione di testi di tipo umano.

Anche in questo caso, è previsa l’estensione dell’approccio basata sui rischi crescenti, con focus sulle maggiori criticità sistemiche.

Vediamoli nello specifico in cosa consistono le quattro maggiori categorie di rischio individuate dalla legge.

Il rischio minimo riguarda un po’ tutti i modelli AI oggi esistenti, che non sono soggetti a particolari obblighi ai sensi della legge sull’IA, proprio a causa del loro livello minimo di rischio per i diritti e la sicurezza dei cittadini. In questo caso, le imprese possono adottare volontariamente codici di condotta aggiuntivi.

Passando al rischio specifico per la trasparenza, invece, l’obiettivo è fare in modo che i sistemi AI, come i chatbot, comunichino sempre e in maniera chiara agli utenti che stanno interagendo con una macchina. Alcuni contenuti generati dall’intelligenza artificiale, compresi i deep fake, devono essere etichettati come tali e gli utenti devono essere informati in caso di impiego di sistemi di categorizzazione biometrica o di riconoscimento delle emozioni.

AI, ecco i rischi maggiori

I sistemi di AI identificati come ad alto rischio, invece, saranno tenuti a rispettare requisiti più rigorosi, tra cui dotazioni di sistemi di attenuazione dei rischi, elevata qualità dei set di dati, registrazione delle attività, documentazione dettagliata, informazioni chiare per gli utenti, sorveglianza umana ed elevati livelli di robustezza, accuratezza e cybersecurity.

Si parla, infine, di rischio inaccettabile, quando si è di fronte a modelli di AI considerati una chiara minaccia per i diritti fondamentali delle persone, che quindi dovranno essere vietati. Sono compresi in questa categoria tutti i sistemi o le applicazioni che manipolano il comportamento umano, come i giocattoli che utilizzano l’assistenza vocale che facilmente possono indurre nei minori comportamenti pericolosi, i sistemi che consentono il “punteggio sociale” da parte di governi o imprese e alcune applicazioni di polizia predittiva da parte delle Forze dell’ordine.

Le imprese che non rispettano le norme saranno sanzionate. Le sanzioni pecuniarie potrebbero arrivare fino al 7 % del fatturato annuo globale per le violazioni di applicazioni di IA vietate, fino al 3 % per le violazioni di altri obblighi e fino al 1,5 % per la fornitura di informazioni inesatte.