Ars Artificialis: una rubrica a cura di Nicola Grandis.

Parlare e dialogare sulla migliore approssimazione di Arte Artificiale realizzata sin qui dall’uomo, quella che comunemente viene definita Intelligenza Artificiale. Per leggere tutti gli articoli clicca qui.

È in corso un processo, il DOJ USA vs Google. Promosso da una pletora di attori tra cui 20 associazioni no profit, il processo storico verte sulla posizione monopolistica di Google nel mondo dei motori di ricerca.

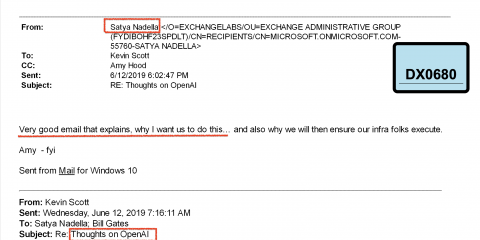

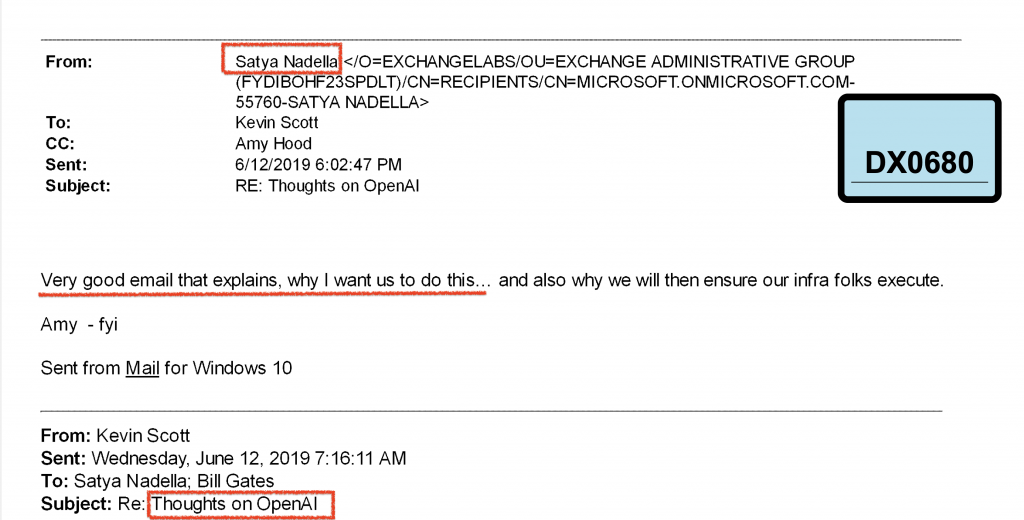

Nel processo è entrato un altro documento storico, un’email tra il CEO di Microsoft Nadella, il CFO, il CTO e Bill Gates. L’email partita da Scott, il CTO fa riferimento al fatto che Microsoft sia anni indietro rispetto a BigG nel settore dell’AI, Nadella coglie il messaggio ed ingaggia il CFO per sondare OpenAI di Altman, in 2 settimane Microsoft investe il primo Billion in OpenAI, col tempo siamo giunti a 13 Billions e recentemente Nadella ha anche dichiarato di aver sovrastimato sia l’operazione che l’impatto dell’Intelligenza Artificiale nel panorama della Internet Search, ma ormai, si direbbe che alea iacta est, ed i denari anche.

Ecco l’email con oggetto “Thoughts on OpenAI“

Sarà il processo a stabilire le posizioni di Google rispetto alle richieste del DOJ ed i denari investiti da Nadella saranno giudicati dagli investitori, ma il documento è davvero interessante per la posizione di Scott, il CTO di Microsoft. Si legge un bel po’ di confusione tra AI, ML, modelli BERT (Bidirectional Encoder di Google Research, 2018), piattaforma, astrazione, capacità di training. Il documento è in larga parte Redacted, quindi non si può cogliere il senso completo ed il tenore degli scambi precedenti, ma Scott è molto impreciso nei termini.

In particolare Scott è colpito dall’utilizzo di BigG di BERT per la funzionalità di autocompletamento della ricerca. Si tratta di quella funzionalità che consente a Google di suggerirci termini da aggiungere alla ricerca mentre digitiamo.

Ci sono dei MA:

BERT è un Transformer “Decoder Only”, non può ricevere un prompt per generare testo, ma è bravissimo a predire la prossima parola dato un testo.

BERT lavora su un context molto piccolo, tipicamente 512 parole (che sono anche troppe), mentre un LLM lavora su context da migliaia o decine di migliaia di parole. Il costo computazionale di un Transformer segue il quadrato della dimensione del Context.

BERT è agile in inferenza e scala bene su miliardi di utenti senza necessità di andare su GPU (costosissime schede NVidia), gli sono sufficienti le TPU prodotte da ARM, che costano poco e possono servire migliaia di utenti ciascuna con modelli piccoli come BERT.

E quindi arriviamo al SE:

E se Microsoft avesse puntato nella direzione sbagliata?

Un LLM (ChatGTP) non ha alcun ruolo attivo nella ricerca di informazioni, al massimo può fare una sintesi di ciò che un motore di ricerca trova. Si tratta di modelli enormi ed energivori che non possono attualmente scalare a miliardi di utenti. Ed effettivamente, nonostante i 13 BLN in OpenAI, Bing non sta brillando. Dalla email di Scott (2019) ad oggi, Microsoft sta tentando di riciclare l’investimento in Co-Pilot, AI per Office, ma è già il prodotto di punta dell’azienda di Redmond. Improbabile che l’investimento sia stato pensato per migliorare dove si ha il quasi-monopolio.

Nello scambio finale, quello in cui Nadella incarica il CFO di dirigersi su OpenAI, Gates sembra essere tenuto fuori, tolto dai CC. Ci saranno stati altri interventi e si saranno avute altre discussioni in Microsoft, ma nel momento della decisione, il fondatore dell’azienda, il lungimirante Zio Bill viene estromesso dal confronto. Sembra strano.

Dopo BERT, BigG ha perfezionato lo strumento con RoBERTa e una lunga serie di cugini, che sono poi solo quelli di cui esistono pubblicazioni scientifiche. C’è da immaginare che l’implementazione di autocomplete di BigG contenga una secret sauce da cui non ci si voglia separare.

Ricapitolando:

Scott (Microsoft CTO) scrive di trovarsi anni indietro rispetto a Google su AI e di essere spaventato dal modello di autocomplete della ricerca di BigG.

Nadella, in risposta, avvia il processo che porterà Microsoft ad investire 13 BLN in OpenAI.

Ma OpenAI lavora su AGI, modelli evoluti, chatbot. Nulla che si avvicini ad un BERT.

La storia ha anche un seguito divertente: utilizzando anche i fondi di Microsoft, sembra che OpenAI stia facendo head-hunting su personale che lavora all’AI di Google offendo 10 MLN/anno di salario.

E la dicotomia persone/tecnologia sale a livello GOV quando pochi giorni fa, tutte le Giant Tech hanno chiesto al Presidente Biden di semplificare il processo di americanizzazione per i talenti dell’AI, i quali non hanno voglia di attendere anni per la green card e vogliono lavorare subito, con meno controlli anti-terrorismo, meno burocrazia e possibilmente meno tasse degli altri.

Ebbene. Il tono divulgativo del presente articolo impone di sorvolare sul dettaglio tecnico e di porre quesiti retorici il cui unico scopo è quello di far ragionare il lettore curioso. È evidente che Microsoft e Scott avessero mire differenti, così come è vero che sbagliare un investimento di 13 BLN quando l’azienda vale 3 TRL è decisamente ammesso, sempre che poi lo abbiano sbagliato. Magari tra un po’ Bing farà meno schifo, Co-Pilot sarà meno stupido e Google invece verrà azzerata dal DOJ.

È sempre difficile cogliere un fenomeno in corso, ma possiamo dire che anche in questa storia emerge che l’AI è certamente una tecnologia breakout, sicuramente una leva finanziaria potentissima, ma anche nella storia di oggi il ruolo delle persone è fondamentale. Non sono serviti 13 miliardi di investimento a battere un manipolo di ricercatori che hanno pensato a BERT per completare le ricerche di 6 MLD di utenti, milioni di volte al secondo, su scala globale.

Jacob Devlin, in un certo senso il protagonista di tutta la vicenda, primo firmatario del paper di ricerca su BERT con 100k citazioni all’attivo nel 2023 è effettivamente transitato da Google ad OpenAI, ufficialmente in polemica con Bard, il primo Chatbot rilasciato da BigG (che effettivamente era abbastanza penoso), ma servirà un altro processo, un altro ordine di un giudice per far emergere delle email che ci sveleranno il danaroso retroscena della vicenda nel suo complesso. Per ora, quello che le Giant Tech hanno imparato a proprie spese e su cui è arrivato a ragionare anche il Governo americano è che l’AI ha bisogno di un’infrastruttura di calcolo che richiede ingenti investimenti ed un’infrastruttura umana di talenti che richiede invece di essere pagata profumatamente considerata la scarsità della materia prima: il cervello, l’intuizione.

Per approfondire: