Italia

“Calcolo scientifico nella fisica italiana“: il titolo è professionale come s’addice a un congresso di scienziati ma, nel corso della riunione che si terrà dal 27 al 31 maggio tra Rimini e Senigallia, c’è tutta l’affascinante storia dei supercomputer e delle loro straordinarie applicazioni in ogni campo della ricerca.

Anche se la parola supercomputer evoca macchine e applicazioni da fantascienza, essa è stata coniata quasi un secolo fa e indica quegli strumenti di calcolo capaci di svolgere operazioni complesse ad alte velocità. Fino a pochi anni fa i supercomputer erano macchine con materiali speciali e architetture particolari, oggi, dati i progressi dell’informatica, sono costituite da “grappoli” di decine di migliaia di unità di calcolo (CPU) non dissimili da quella esistente nel nostro personal computer, organizzati in una griglia computazionale (Grid), distribuita e organizzata su scala planetaria, che costituisce la base della rete Internet del futuro e le cui risorse saranno presto disponibili anche al di fuori del mondo della ricerca.

Il convegno di Rimini/Senigallia vedrà riuniti tutti i principali utenti scientifici italiani di supercomputer: Enti di ricerca come CNR, ENEA, INGV, INFN, INAF, importanti Atenei Italiani, i grandi centri di calcolo inter-universitari (Caspur, Cilea, Cineca) e il Consortium Garr che gestisce e sviluppa la rete informatica della ricerca italiana.

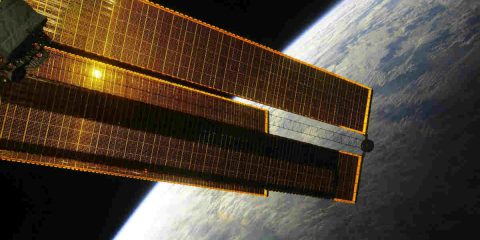

I relatori che si avvicenderanno nei cinque giorni del convegno e nella tavola rotonda conclusiva (sabato 31 maggio) avranno il compito di illustrare le applicazioni del super calcolo nei settori di Scienza della Terra, Fisica nucleare e Sub-nucleare, Biologia, Astrofisica, Struttura della materia, Plasmi, Aerospazio. L’obiettivo dell’incontro non è soltanto quello di una reciproca informazione per mettere a confronto materiali e metodi di studio, ma soprattutto un tentativo di ottimizzare e di accrescere le risorse di supercalcolo esistenti nel nostro paese allo scopo di renderle disponibili con le migliori prestazioni e in maggior quantità a tutti gli scienziati italiani.

Per effettuare modelli e simulazioni necessarie a descrivere, per esempio, l’evoluzione del clima futuro, la dinamica dell’interno della Terra, il comportamento delle particelle elementari nei grandi acceleratori o l’evoluzione di una stella, il mondo della ricerca italiana ha un bisogno vitale di moderne infrastrutture di supercomputer. Oggi i sistemi più avanzati messi a punto da aziende leader internazionali come IBM, Nec, Hp, ecc. sono giunti al traguardo di un petaflop cioè un milione di miliardi di operazioni al secondo. Ma, fanno notare alcuni esperti il nostro cervello, con la sua intricata rete di neuroni e di sinapsi è ancora imbattuto perché può arrivare, virtualmente, a 10 petaflop.