Le tecnologie emergenti possono beneficiare delle elevate prestazioni del 5G per essere impiegate nei diversi progetti di trasformazione digitale delle nostre industrie, della nostra economica, delle nostre città. Parliamo ad esempio di soluzioni che sfruttano anche l’intelligenza artificiale, il machine learning, l’edge computing.

Il rapido aumento dei dati provenienti da sensori, macchinari e social network, pone importanti sfide su come gestire questi enormi flussi di informazioni: sono necessari approcci innovativi, tecnologie hardware e software in grado di gestire “big data”, che rispondano anche alla crescente preoccupazione per la privacy e per le minacce alla sicurezza.

Il progetto “Braine”

Di tutto questo si occupa il progetto europeo “Braine”, (“Big data pRocessing and Artificial Intelligence at the Network Edge”), finanziato dal programma Horizon 2020 e di durata triennale, che è coordinato da Filippo Cugini del Consorzio Nazionale Interuniversitario per le Telecomunicazioni (CNIT) e a cui partecipa come partner l’Istituto di Tecnologie della Comunicazione, dell’Informazione e della Percezione (Tecip) della Scuola Superiore Sant’Anna di Pisa.

I ricercatori impegnati nel progetto “Braine” intendono sviluppare una cornice di “edge computing” potenziata dall’utilizzo di tecnologie di intelligenza artificiali e in grado di processare “big data” a livello locale.

La divisione di networking dell’Istituto Tecip della Scuola Superiore Sant’Anna di Pisa, partecipa al progetto, coordinata da Luca Valcarenghi, docente di telecomunicazioni del Laboratorio Inrete, per implementare un prototipo di un nodo 5G che sfrutta le funzionalità di un hardware dinamico e programmabile per svolgere funzioni proprie di una rete 5G.

Il “nodo 5G”

“Il nodo è un misto tra tecnologia 5G ed edge computing. Il nuovo standard di rete mobile fornisce la connettività necessaria per elaborare i dati di prossimità, cioè per supportare l’edge stesso”, ha spiegato Valcarenghi a Key4biz.

“Il 5G fornisce la connettività necessaria per raccogliere i dati che poi saranno trasferiti al nodo per l’elaborazione e quindi passati al core della rete”, ha aggiunto il professore.

“Se devo cifrare dei dati o riconoscere delle feature, tra cui il riconoscimento facciale o di automobili nel traffico della smart city, per fare un esempio, o anche informazioni cliniche per l’eHealth, lo faccio in edge, in modo di evitare di dover trasportare ogni volta enormi quantità di dati al core”.

L’edge computing

Quello che viene definito “edge computing” è un nuovo approccio per le architetture di rete che permette scalabilità, bassa latenza, “processo” e “storage decentralizzato”, grazie al posizionamento del sistema di processamento dei dati vicino alla sorgente.

Oggi il trend è pre-elaborare all’edge per poi inviare un “semilavorato” di dati al core, se necessario: “Per garantire al 5G le prestazioni necessarie di cui tutti parliamo, tra cui la bassa latenza, il nodo edge, che incorpora non solo central processing unit o CPU, cioè elaboratori classici, ma anche hardware programmabile, come le GPU o graphics processing unit e le Fpga o Field Programmable Gate Array, deve permettere di elaborare il pacchetto di dati in tempi sempre più brevi”, ha precisato Valcarenghi.

“Un nodo è caratterizzato da una doppia valenza: da una parte il 5G serve a connettere il nodo per ulteriori elaborazioni, dall’altra il nodo serve a migliorare le prestazioni di questa nuova rete”.

Il team, è spiegato in un comunicato dell’Ateneo, si occuperà anche dello sviluppo di soluzioni per l’analisi di dati basata su meccanismi di intelligenza artificiale e machine learning e delle previsioni per l’orchestrazione e l’allocazione distribuita di base station, chiamate gNB, nell’ambito delle reti 5G e virtualizzate, e della definizione degli indicatori di performance.

Il gruppo di ricerca della Scuola Superiore Sant’Anna sarà inoltre coinvolto nella fase di testing dei prototipi dei nodi 5G già sviluppati e del “caso di utilizzo” o use case, relativo alle smart cities.

5G, casi di utilizzo

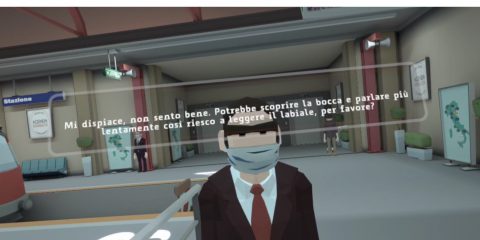

Il progetto prevede test e validazioni dei risultati tramite quattro differenti casi di utilizzo: healthcare assisted living (sanità e telemedicina), hyper-connected smart city (città intelligenti), robotica e supply chain (risparmio di energia) per l’industria 4.0.

Nel campo dell’assistenza sanitaria, l’intelligenza artificiale, il machine learning e l’edge computing possono essere utilizzati in sistemi di smart hospital e “caregiving” per la diagnostica medica, agevolando una previsione automatica e precisa delle condizioni di salute nel monitoraggio da casa delle condizioni del paziente.

Nel caso dell’intelligenza artificiale, ci ha spiegato Valcarenghi, “L’IA è impiegata per ottimizzare il posizionamento di funzioni nell’ambito dell’architettura, con l’obiettivo di garantire le migliori prestazioni. L’IA è anche applicata alle funzioni 5G che vengono virtualizzate, cioè messe su macchine virtuali piazzate su vari nodi di edge, e in base al feedback ricevuto da misure sulla rete si possono poi piazzare i nodi stessi sempre per garantire le migliori prestazioni. Ulteriore applicazione dell’IA è nel riconoscimento delle immagini”.

In ambito urbanistico, il progetto potrà contribuire a creare una “città intelligente iperconnessa”, una smart city con servizi più avanzati, più vivibile grazie all’utilizzo di una varietà di sensori per raccogliere informazioni e, in base ad esse, offrire servizi mirati. In questo caso una dimistrazione finale sarà svolta nella città di Pisa.

Smart city e industry 4.0

Per la smart city, si tratta di “un’elaborazione segnali audio e video ottenuti da rete di videocamere per ottenere una datafusion di dati audiovisivi nell’edge, in modo da combinare informazioni di diversa origine per dare delle indicazioni più precise su un evento”, ha detto il docente della Sant’Anna.

Nel contesto dell’industria 4.0 la piattaforma del progetto potrà favorire l’integrazione della robotica nei processi di produzione industriale, passando da applicazioni nel settore automobilistico (autonomous vehicle) a funzioni più autonome come quella del “digital twin”, alter ego virtuale e smart di processi, prodotti, sistemi e infrastrutture, che consentono un’ottimizzazione della produzione in molti settori, migliorando efficienza, tempistiche, manutenzione, flessibilità.