Il ruolo del 5G nel futuro della nostra società e i suoi effetti sullo sviluppo economico e sociale legato a questa tecnologia rivoluzionaria. Ecco cosa ha detto Antonio Sassano, presidente della Fondazione Ugo Bordoni (FUB), in audizione in IX Commissione Trasporti, Poste e Telecomunicazioni nell’ambito dell’indagine conoscitiva sulle nuove tecnologie 5G e big data che si è tenuta lo scorso 24 luglio.

1. Il 5G: Reti di Reti e creazione di valore

“Molti di coloro che sono intervenuti nelle precedenti audizioni hanno già descritto gli elementi di novità della tecnologia 5G – ha detto Sassano – dall’aumento della capacità di trasmissione fino a 1Gbit/sec alla possibilità di realizzare collegamenti a bassissima latenza tra milioni di oggetti, abilitando la cosiddetta Internet delle Cose. Credo sia utile, per una vostra miglior comprensione del fenomeno, che la Fondazione Bordoni affronti, nel breve tempo a disposizione, un tema finora poco approfondito ma di grande importanza per il futuro del Paese: l’effetto del 5G sulla creazione di nuovo valore grazie alla mutazione della struttura dei rapporti tra le società di telecomunicazioni, i grandi attori dei mercati “verticali” (energia, automotive, e-health) e i cosiddetti “micro operatori locali” che saranno abilitati dalla struttura delle reti 5G a realizzare reti in ambito geograficamente ristretto e altamente specializzato (porti, aeroporti, stadi, ospedali, etc.)”.

Reti virtuali

La tecnologia 5G consentirà di definire reti virtuali che utilizzano e coordinano collegamenti fisici per ottimizzare la qualità dei servizi offerti agli utenti. “Ogni servizio definirà la sua rete: reti composte di trasmettitori distribuiti capillarmente sul territorio e capacità di elaborazione distribuita (“edge computing”) per realizzare i veicoli a guida assistita o autonoma; reti composte da un “cloud” di server (Content Distribution Network) e collegamenti FTTH o Fixed Wireless Access per distribuire servizi video in altissima definizione; reti con alta copertura, affidabilità e ridondanza ma non necessariamente a larghissima banda per collegare e gestire miliardi di oggetti connessi, ad esempio, lungo la catena logistica. Infine, reti con struttura adatta a servizi che in questo momento non immaginiamo ma che, forse, saranno i servizi indispensabili del prossimo decennio. Dunque, servizi che definiscono le reti e non più servizi che utilizzano al meglio le reti disponibili”.

Reti classiche

“Le reti classiche, storicamente dedicate alla connessione a bassa capacità di utenti umani (telefonia e internet agli esordi) lasceranno il posto a reti di reti che connetteranno miliardi di oggetti, in tutti i settori industriali – continua Sassano – dalle automobili ai robot industriali; dai misuratori/sensori agli oggetti indossabili. Centinaia di reti autonome, da quella delle automobili Volkswagen, a quella dei lampioni di Milano, o dei robot di una grande fabbrica o del Porto di Genova o di un grande ospedale. Il traffico muterà natura e da “verticale” (dagli utenti alle centrali e dalle centrali agli utenti) diventerà prevalentemente “orizzontale” (tra gli oggetti) con spostamento della domanda di elaborazione dal centro (“cloud centralizzato”) alla periferia (“edge computing”)”.

Reti non più soltanto social tra umani

Si tratta di una trasformazione radicale delle reti di comunicazione, prosegue, e del modo di strutturare produzione e servizi. Finora la Rete ha sviluppato, precisa il Presidente della FUB, “le sue potenzialità come abilitatrice della comunicazione tra umani (le reti social) mentre, con la nuova generazione, oggetti come gli autoveicoli, le macchine utensili, i sistemi di generazione dell’energia, le flotte di navi e tutti gli elementi delle catene logistiche, per dirne alcuni, diverranno coordinabili e ottimizzabili da parte di sofisticati algoritmi (tornerò su questo punto nella parte dedicata all’Intelligenza Artificiale) che si baseranno su dati grezzi e informazioni prodotte “on-line” (velocità e consumi ad esempio) e produrranno dati di altissima qualità informativa (profilazioni, stili di guida, regole nuove di produzione, abitudini di consumo energetico, stato delle infrastrutture etc.)”.

Reti del futuro nasceranno da processo federativo dal basso

Le reti del futuro nasceranno anche da un processo “federativo”, dal basso. “Interi settori industriali scopriranno il valore di “mettere in rete i propri oggetti”, dei nuovi dati grezzi generabili e delle informazioni di altissima qualità che gli algoritmi possono produrre. Dunque, algoritmi e dati “interni” al proprio dominio applicativo (automotive, logistica, energia, salute), da valorizzare e proteggere e dei quali contrattare la condivisione con coloro che fino ad oggi avevano connesso gli umani (gli operatori di telecomunicazioni) o avevano scoperto e raccolto il valore di queste connessioni tra umani (gli operatori delle grandi piattaforme del Web)”, aggiunge Sassano.

Un esempio per tutti: le reti di automobili

“Finora le auto sono state oggetti “non connessi” – dice Sassano – Raggiunte in modalità “broadcast” dalle radio (molto) e dalle televisioni (poco), hanno consentito a questi operatori di raccogliere il valore di questa connessione unidirezionale. I dati prodotti dalle automobili sono stati finora raccolti “off line” dalle case automobilistiche e costituiscono un patrimonio informativo riservato di queste ultime. Il proprietario dell’auto non ha mai forse neanche saputo di raccogliere dati e informazioni molto preziose per le case costruttrici – prosegue – Ora tutto cambia. Con la tecnologia 5G, le auto possono essere connesse tra loro e scambiarsi informazioni sul proprio funzionamento e sul traffico a breve e lunga distanza. Le strade saranno attrezzate con infrastrutture intelligenti e sistemi di comunicazione a bassissima latenza: computer in grado di eseguire complessi algoritmi di ottimizzazione basati sui dati raccolti “on-line” e aiutare il guidatore fino a sostituirsi a lui”.

Automotive, si allarga la platea dei player interessati ai dati

“Ovviamente le case automobilistiche cercheranno di valorizzare i dati prodotti da queste nuove reti di auto, sensori e computer. Ma, nella logica della “scoperta del valore”, altrettanto faranno i proprietari dei veicoli, i gestori di strade e autostrade che vorranno valorizzare i dati raccolti e processati dai loro apparati, i proprietari degli algoritmi di ottimizzazione che, grazie all’esperienza accumulata sul campo, miglioreranno le loro prestazioni ed infine gli operatori di telecomunicazioni che avranno reso possibile la comunicazione. Come si vede, produzione di nuovo valore e nuova competizione sull’intelligenza degli algoritmi e sui dati di qualità prodotti da questi ultimi. Esempi analoghi possono essere formulati con riferimento alle fabbriche di Industria 4.0, alle “smart grid” energetiche e alle reti legate alla catena logistica (navi, camion, treni, porti, stazioni, nodi di interscambio)”.

Tutti i settori produttivi avranno bisogno di porzioni di rete

“E dunque, se è vero che tutte le attività umane si digitalizzeranno, tutti i settori produttivi, presenti e futuri, avranno bisogno di accedere a porzioni di rete (frequenze, trasmettitori e fibra) per connettere i propri oggetti tra loro e con tutti gli altri. Nessuno sarà più “utente” degli operatori di comunicazione ma tutti chiederanno di comunicare”, aggiunge Sassano.

Integrazione verticale degli operatori superata

“In questo scenario – secondo Sassano – l’integrazione verticale degli operatori classici di telecomunicazioni, ovvero lo schema antico di connettere gli utenti finali e fornire loro tutti i servizi sarà definitivamente consegnato alla Storia. Nessun fornitore di servizi affiderà alle Telco la gestione del suo “core business”. Dai grandi produttori di autoveicoli, ai produttori di oggetti indossabili, ai gestori delle città e delle reti energetiche. Tutti chiederanno accesso alle “slice” del 5G ma tutti difenderanno il perimetro dei propri servizi e soprattutto i dati che questi ultimi genereranno”.

Reti virtuali “slice” specializzate in nuovi servizi

“Possiamo dunque concludere che in futuro esisterà molto meno spazio per i fornitori di mero servizio di connettività agli utenti finali (telefonia fissa e mobile). La reti del futuro dovranno consentire la realizzazione di reti virtuali specializzate per nuovi servizi. L’accesso all’utente finale e ai suoi dati sarà prevalentemente mediato dai fornitori di servizi che utilizzeranno “slice” della rete 5G per connettere i propri “oggetti””, dice il Presidente, secondo cui non saranno solo le Telco a realizzare la guida autonoma o le smart grid ma anche e soprattutto le aziende automotive e quelle energetiche.

Non solo Telco, nuovi player in arrivo

“Quello che è accaduto con gli OTT sul Web avverrà con tutti gli altri servizi. Grandi reti di oggetti (veicoli, “wearable”, infrastrutture di ogni tipo) potrebbero connettersi tra loro senza bisogno di un operatore di telecomunicazioni specializzato, magari utilizzando frequenze “ad accesso libero” (WiFi) o partecipando alle aste future per frequenze licenziate”, aggiunge Sassano.

“La connessione delle abitazioni potrebbe non essere più l’obiettivo principale della rete. L’acronimo FTTH (cioè la fibra all’abitazione – H sta per Home) potrebbe non essere più l’unico sinonimo di “infrastrutture a prova di futuro” ed essere affiancato dalla “fibra alle base station” o dalla “fibra alle infrastrutture” o dalla “fibra ad Industria 4.0“. O, più in generale, dall’obiettivo della copertura (fissa, wireless, rame o fibra) ad alta capacità e bassa latenza del 100% del territorio”,ha detto Sassano in audizione.

“Gli operatori di telecomunicazioni non saranno più i soli ad estrarre valore dal collegamento di milioni di oggetti e dallo sviluppo di nuove applicazioni basate sulle reti dei mercati verticali (case automobilistiche, utilities, operatori della catena logistica). Al contrario, saranno costretti ad accordarsi con questi ultimi per realizzare le “slice” logiche della rete 5G. Un accordo e una collaborazione che potrebbe facilitare gli investimenti nel 5G (previsti per centinaia di miliardi di dollari a livello mondiale) ed accelerare il passo di questa indispensabile trasformazione industriale”, ritiene il Presidente della FUB.

5G, reti eterogenee. Accordi fra Telco sempre più comuni

“Le nuove reti 5G consentiranno la realizzazione di reti eterogenee, “composte da un “mix” di macro e micro celle che utilizzano in modo coordinato nuove bande di frequenza con coperture molto diverse – prevede Sassano – Questa maggior complessità ha come conseguenza l’aumento dell’attività computazionale nei nodi di rete e la necessità di una gestione ottimizzata e centralizzata dei punti di trasmissione. Recenti studi mostrano che il 50% del consumo energetico delle future reti wireless 5G sarà causato dall’attività di elaborazione delle informazioni piuttosto che dalla trasmissione vera e propria. Non dobbiamo dunque meravigliarci della sempre più diffusa definizione di accordi tra operatori di telecomunicazioni per la gestione comune di fibra, torri e spettro e della nascita di operatori “wholesale only” o di “neutral host” per la gestione delle frequenze nelle reti virtualizzate”.

Spettro radio, cresce la domanda di spettro dedicato per uso locale

L’elemento di novità nell’attuale panorama della gestione dello spettro, aggiunge Sassano, è piuttosto “la forte richiesta, da parte di nuovi attori di mercato, di porzioni dedicate dello spettro per un uso definito “regionale” o “locale”. La richiesta di “spettro dedicato” viene dai grandi operatori dominanti nei mercati dell’automotive, dell’energia o dell’e-health”. Si tratta spesso di grandi campioni nazionali (come le grandi case automobilistiche o il complesso delle manifatturiere), che stanno a cuore ai governi e che presentano “la richiesta di un accesso preferenziale a porzioni dedicate dello spettro come uno dei punti qualificanti di una politica industriale nazionale”, precisa Sassano.

Uso regionale dello spettro, l’esempio della Germania

Ad esempio, rispondendo a questa pressione, l’asta 5G tedesca ha riservato, nella preziosissima banda 3.5 GHZ, un blocco di 100MHz per un uso “regionale”. “In realtà, una lettura accurata delle motivazioni alla base delle regole di gara mostra che uno degli obiettivi del regolatore tedesco era quello di mettere a disposizione spettro dedicato per gli strategici “vertical” automobilistico e dell’Industria 4.0. Questa scelta ha ovviamente reso molto più dura la competizione degli operatori di telecomunicazioni sui 300 MHz residui”, aggiunge il presidente della FUB.

Mercato 5G, non solo grandi player ma micro operatori

“A rendere il quadro ancora più complesso si aggiunge la circostanza che la richiesta di riservare porzioni di spettro ad uso “locale” non viene esclusivamente dalle grandi “industry” verticali del nascente mercato 5G, ma anche dai cosiddetti micro operatori, ovvero operatori che hanno un ruolo di “local incumbent” in mercati molto ristretti: un porto, una stazione ferroviaria, un aeroporto, un ufficio postale, una grande installazione industriale – prevede Sassano – Potrebbe trattarsi di ISP, di operatori specializzati o degli stessi gestori o proprietari dell’infrastruttura. Recenti studi hanno mostrato come il ruolo dei micro operatori sia molto competitivo con quello dei grandi “provider” di connettività”.

Micro reti 5G

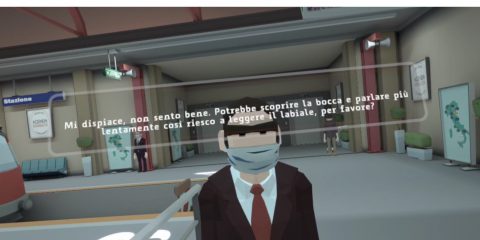

Le competenze specifiche richieste per garantire il servizio sulle micro reti 5G, la necessità di controllare e gestire in tempo reale reti di sensori e attuatori ad altissima densità, l’obiettivo di gestire “in casa” dell’utente e con le massime garanzie di sicurezza gli algoritmi di ottimizzazione ed enormi moli di dati, “sono caratteristiche molto diverse da quelle del business classico dell’operatore di telecomunicazioni, certamente abituato a connettere migliaia di utenti ma non a garantire l’azione coordinata di uomini e apparati per il raggiungimento di sofisticati obiettivi industriali o di servizio”, dice Sassano, secondo cui dunque, piattaforme hardware e software flessibili, gestite da micro operatori specializzati, potrebbero essere in grado di rispondere meglio alle esigenze di Industria 4.0 o dei futuri servizi “data intensive” agli utenti e, quindi, richiedere l’uso di spettro dedicato e non più gestito dagli operatori di telecomunicazioni.

Le conseguenze di questa mutazione nella politica di gestione dello spettro

“Gli operatori di telecomunicazioni hanno spesso lamentato gli alti costi delle licenze delle frequenze e richiesto insistentemente al Parlamento e al Governo di metterle a loro disposizione in modo gratuito a fronte di impegni di copertura – ha detto Sassano – Questa richiesta, a mio parere, non risponde più alle mutate condizioni tecnologiche e di mercato. Tutti i settori industriali potrebbero richiedere, a buon diritto, questa assegnazione gratuita, ponendo allo Stato un problema di scelta tra i possibili assegnatari. Dunque, possiamo considerare chiuso il dibattito sul metodo migliore per assegnare le frequenze. Ne esistono solo due, entrambi efficienti: per mezzo di procedure competitive finalizzate all’assegnazione esclusiva o con la condivisione”.

Il controllo dello spettro è un vantaggio per gli operatori

Piuttosto, “gli operatori di telecomunicazioni dovrebbero riconoscere che uno dei loro maggiori vantaggi competitivi nello scenario attuale deriva dal controllo dello spettro e, strategicamente, ricordare ai Governi di aver pagato (e molto) per averne l’uso esclusivo e pretendere che, anche in futuro, porzioni analoghe dello spettro vengano assegnate con procedure competitive che meglio ne rivelano il grande valore industriale e sociale. Le Istituzioni, a loro volta, dovrebbero meglio valutare la qualità e l’utilizzazione dello spettro elettromagnetico, avviando accurate analisi degli usi attuali di questa preziosa risorsa, evitando le situazioni di sottoutilizzazione e accaparramento e, soprattutto, evitando accuratamente di assegnare ad operatori in concorrenza tra loro porzioni di spettro equivalenti a condizioni economiche o con impegni di copertura molto diversi”.

WRC-19

Insomma, un’attenta politica di gestione dello spettro, accompagnata da una presenza propositiva e attiva negli organismi di coordinamento internazionale. Il 2019 è l’anno della Conferenza Mondiale delle Telecomunicazioni di Ginevra. “Nel prossimo novembre tutti i paesi membri dell’ITU dovranno esprimersi su temi importanti quali le nuove bande di frequenza per il 5G e l’uso futuro delle frequenze della banda UHF. La voce dell’Italia sarà più forte se sarà coordinata con quella degli altri Paesi UE ma sarà fondamentale che il Parlamento, il Governo e l’Agcom si presentino a questo importantissimo appuntamento con un punto di vista che difenda e valorizzi le specificità del nostro Paese”, ha detto il presidente.

2. Intelligenza Artificiale, Ottimizzazione e Dati

“L’Intelligenza Artificiale non è qualcosa di prossimo venturo ma è già presente in modo capillare e pervasivo nella nostra società dominata dagli algoritmi”, ha detto Sassano in audizione.

Abbiamo finora trattato l’Intelligenza Artificiale (IA) come se si trattasse di uno tsunami in arrivo. Tutti i rapporti dei gruppi di studio europei ed extraeuropei hanno studiato e presentato l’Intelligenza Artificiale, in modo a volte positivo e a volte distopico, come l’avvento della società delle macchine o la sostituzione dell’intelligenza umana. Abbiamo visto nascere più gruppi di studio sulle conseguenze etiche, sociali e politiche dell’IA che sulle sue basi matematiche o sui suoi strumenti metodologici. In realtà, l’Intelligenza Artificiale, nella sua più ampia accezione di insieme di metodologie atte ad affrontare e risolvere in modo automatico i problemi della società è già da tempo in pieno sviluppo e fioritura, ha detto Sassano.

“Non si tratta di metodologie e strumenti prossimi venturi ma di metodologie, modelli, tecniche di soluzione e algoritmi applicati a quasi tutte le attività umane. Da più di cinquanta anni e con successo crescente, la matematica applicata e gli algoritmi di ottimizzazione e simulazione risolvono problemi di logistica, trasporto, automazione industriale, progetto di reti e servizi, guida automatica e, più di recente, di bioinformatica e di riconoscimento della voce e delle immagini – dice Sassano – L’avventura dell’uomo sulla Luna di 50 anni fa è stata resa possibile da algoritmi innovativi che hanno risolto in modo automatico il complesso problema del controllo di assetto e volo delle navicelle spaziali in viaggio dalla Terra alla Luna. La decisione di procedere con la discesa verso la Luna, anche di fronte ad un algoritmo che segnalava un errore, è forse il primo esempio di condivisione di responsabilità tra uomo e algoritmo”.

“Si è trattato dunque di 50 anni di continuo miglioramento della capacità degli algoritmi di risolvere problemi – ha aggiunto – Sento spesso raccontare la storia dell’Intelligenza Artificiale come una storia di “alti e bassi”, con esaltazioni e delusioni. Questo racconto vale certamente per la ristretta comunità dell’Intelligenza Artificiale Generale e le aspettative dei non addetti ai lavori, che spesso sono i più attivi nel raccontarci il futuro. La storia del settore più vasto dei metodi di ottimizzazione è stata invece caratterizzata da un aumento costante della dimensione, della pervasività e della complessità dei problemi risolti dagli algoritmi”, ha aggiunto.

Alcuni algoritmi imparano a risolvere problemi

“Alcuni di questi algoritmi imparano a risolvere problemi vagliando grandi moli di dati. Altri invece, sulla base degli stessi dati a disposizione degli umani ottengono, in tempi infinitamente più brevi – precisa Sassano – risultati di qualità equivalente o, spesso, molto superiore. Per progettare una rete digitale terrestre non servono “Big Data”. Basta la digitalizzazione delle informazioni utilizzate negli anni ’50. Un modello digitale del territorio, un algoritmo di simulazione della distribuzione dei valori del campo elettromagnetico ma soprattutto un sofisticato algoritmo di ottimizzazione/simulazione che individui le caratteristiche tecniche dei trasmettitori con l’obiettivo di massimizzare la copertura e minimizzare il numero di impianti”.

Algoritmi efficienti

“Dunque, è di metodologie di ottimizzazione, della loro traduzione in algoritmi e di soluzione di problemi che dobbiamo parlare e non solo di dati. E’ la disponibilità di metodi ed algoritmi efficienti che consente alle grandi aziende del Web di profilare i propri utenti. Nella pagina del centro di ricerche Google dedicata all’Intelligenza Artificiale https://ai.google/ sono presenti articoli e riferimenti alle attività di studio dei gruppi di ricerca su “Algoritmi e Ottimizzazione” e “Large Scale Optimization” che non sono invece nemmeno citate in molti dei rapporti nazionali sull’Intelligenza Artificiale predisposti negli ultimi anni”, ha detto Sassano, secondo cui sono i metodi di ottimizzazione e i conseguenti algoritmi che progettano e coordinano macchine utensili, reti di telecomunicazioni e di trasporto e che gestiscono le reti logistiche, le procedure di acquisto e vendita di beni e tutte le attività delle grandi piattaforme del Web. “Questo accade già ora e, come abbiamo visto, saranno metodi di ottimizzazione e algoritmi efficienti a configurare le reti 5G e dunque a rendere possibili tutti i servizi digitali del futuro”, precisa.

Società sempre più dominata dagli algoritmi

“Viviamo in una società sempre più dominata dagli algoritmi eppure non abbiamo alcuno strumento per verificare che effettivamente le soluzioni che gli algoritmi ci propongono siano coerenti con i nostri interessi e con una verificabile impostazione etica. Non esiste, ai massimi livelli decisionali, alcuna percezione del “modus operandi” dei metodi di ottimizzazione e degli algoritmi che li implementano e dunque non siamo neanche in condizione di contrattarne il comportamento come qualcuno ha recentemente proposto”, ha detto il presidente della FUB.

“Gli algoritmi producono soluzioni che rispettano i vincoli logici e fisici e massimizzano indici di efficacia o minimizzano indici di costo. A volte una soluzione può anche essere classificata come ottima (ovvero con le caratteristiche, il costo o l’efficacia migliori di tutte le altre soluzioni). Ma quante sono le soluzioni che hanno lo stesso costo minimo o la stessa massima efficacia e dunque sono altrettanto ottime? Spesso miliardi. E perché un algoritmo ne sceglie una piuttosto che un’altra? A questa domanda neanche l’autore dell’algoritmo sarà in grado di rispondervi. Dunque, è molto difficile regolare il comportamento degli algoritmi e spiegarne le logiche interne”, ha aggiunto.

Un metodo facile ci sarebbe. “Semplificarli per rendere facilmente analizzabile la logica di comportamento. Ma siamo disposti ad avere sistemi di guida automatica degli aerei o di riconoscimento facciale di terroristi meno performanti per poterne comprendere la logica? Penso di no e dunque dobbiamo attrezzarci per utilizzare metodi complessi di analisi del comportamento degli algoritmi. Metodi che dovranno essere utilizzati per verificare tutti gli algoritmi che già ora scandiscono la nostra vita: dalla sicurezza delle infrastrutture critiche previste dal “Golden Power” alla orchestrazione delle reti 5G; dall’assegnazione delle cattedre nella scuola alla gestione ottima dei trapianti di organo”, esemplifica Sassano.

Qualcuno dice: i dati sono il petrolio del futuro. “Mi sembra più corretto dire: così come il petrolio grezzo ha meno valore prima della sua trasformazione, così i dati, anche i BigData, sono valorizzati solo quando un algoritmo li utilizza e li trasforma in informazioni di qualità per trovare soluzioni a problemi rilevanti. Saranno gli algoritmi, la capacità di concepirli, farli funzionare e certificarne il comportamento corretto a creare la ricchezza futura di nazioni e aziende. Confondere la qualità dei metodi di ottimizzazione e degli algoritmi con la quantità dei dati a disposizione è un errore che potrebbe avere conseguenze molto negative”, precisa Sassano.

Centralità dell’algoritmo, fra IoT e decentralizzazione del Web

Questa centralità degli algoritmi, secondo Sassano,sarà amplificata in modo esponenziale dal contemporaneo sviluppo di due innovazioni tecnologiche che giungeranno a maturità nei prossimi anni: l’Internet delle Cose e la decentralizzazione di Internet e del Web. “Entrambe verranno rese possibili dalle reti di nuova generazione: il 5G a partire dal 2020 e le sue future evoluzioni alla fine del prossimo decennio. Le relazioni tra oggetti, il coordinamento di memorie e calcolo distribuiti e lo sviluppo di meccanismi che abiliteranno le transazioni senza intermediari (come la BlockChain) saranno realizzabili soltanto grazie a meccanismi automatici gestiti da algoritmi sempre più sofisticati”, ha detto Sassano in audizione.

A che punto siamo? Servono specialisti

Riconosciuta la centralità dell’algoritmo è necessario chiedersi: a che punto siamo?“Non è facile rispondere a questa domanda – ha detto Sassano – Sappiamo tutto sullo sviluppo della copertura della banda larga o dell’uso di Internet da parte degli utenti ma non esistono dati e indici per misurare la capacità di produrre algoritmi del nostro Paese. L’indice europeo DESI ci dice che non produciamo abbastanza specialisti; che abbiamo pochi laureati nelle discipline STEM. Lasciatemi dire che anche questo dato non dice molto. Purtroppo, non basta essere un ingegnere per essere un esperto di metodi di ottimizzazione e algoritmi. La maggior parte dei laureati in matematica, fisica ed ingegneria meccanica, civile o delle telecomunicazioni, per dirne solo alcuni, hanno una formazione nell’ottimizzazione e una capacità di progettare algoritmi complessi largamente insufficienti. Ovviamente, grazie all’altissima qualità della formazione di base fornita dalle nostre migliori università, sono in grado di riconvertirsi rapidamente ma questo è un processo costoso che la formazione universitaria dovrebbe evitare”.

“Tutti gli altri, laureati o no, non hanno accesso ad una formazione di base su metodi di ottimizzazione e algoritmi. Non sto parlando di capacità di programmare (anche questa molto rara) ma di quella di ideare e progettare un algoritmo per risolvere un problema concreto. Una situazione di “analfabetismo funzionale” di proporzioni davvero preoccupanti. Dunque, è necessario un grande sforzo di formazione di specialisti, con un piano straordinario per formare esperti di metodi di ottimizzazione e algoritmi ma anche per alfabetizzare su questi temi tutti gli altri laureati”.

Monitoraggio degli algoritmi

“Ma questo non basta”, secondo Sassano: “Il nostro Paese dovrebbe realizzare un meccanismo di monitoraggio della diffusione degli algoritmi nella nostra società, nella pubblica amministrazione e nelle aziende private. Chi usa metodi di ottimizzazione ed algoritmi nella soluzione dei suoi problemi di produzione e organizzativi? Chi li ha realizzati aveva le competenze per farlo? Gli algoritmi sono efficienti, rispettano standard di sicurezza e rispondono alle specifiche di chi li ha commissionati? E’ possibile individuare “pratiche di eccellenza” nella soluzione di problemi ricorrenti oppure ogni azienda dei rifiuti italiana utilizza un algoritmo diverso per pianificare le sue attività di raccolta? Qual è la percentuale di aziende italiane che utilizza metodi di ottimizzazione per la realizzazione di algoritmi e quanto dipendiamo da aziende straniere?”.

Domande ragionevoli

“Mi sembrano tutte domande ragionevoli. Siamo attrezzati per rispondere? Dovremo sicuramente attrezzarci per tutti quei settori che le regole della CyberSecurity indicheranno come “critici”. Ma siamo davvero sicuri che queste domande siano superflue nei settori non critici della nostra economia?”, aggiunge Sassano. “Si, tutto bellissimo. 5G, Intelligenza Artificiale, Robot; ma come raccontare l’evoluzione tecnologica ai cittadini, come avvicinarli alla comprensione della rilevanza nella loro vita quotidiana di questi temi?”. “Vorrei rispondere con un paradosso: Non è la percezione dei cittadini il nostro problema, ma la capacità di rispondere efficacemente ad esigenze che per molti di loro sono chiarissime. Minimizzare i tempi di produzione in una fabbrica, ridurre i tempi di consegna, ottimizzare gli orari di lavoro, o i tempi di accettazione in un pronto soccorso, gli orari dei treni o di un servizio di bus, i tempi della raccolta dei rifiuti o i costi di realizzazione di una rete per un qualsiasi servizio sono obiettivi che non debbono essere spiegati a chi si trova ogni giorno a risolvere questi problemi reali. La vera sfida è quella di dare risposte a questa chiara e percepibile richiesta di intervento. Per questo, senza aspettare l’avvento delle macchine intelligenti, che arriveranno tra qualche anno, è necessario, adesso, mettere in campo specialisti in grado di tradurre questi problemi in modelli di ottimizzazione ed algoritmi efficienti”.

3. Soglie sui campi elettromagnetici e 5G

“La Fondazione Bordoni ha dato, in passato, contributi significativi all’importante tema della definizione e della verifica del rispetto delle soglie di campo elettromagnetico ai fini della protezione della salute dei nostri concittadini. Si tratta di un tema di grande delicatezza politica e sociale che vorrei affrontare nel modo più oggettivo possibile”, ha detto Sassano. La posizione della Fondazione su questo tema è la seguente:

La realizzazione delle reti 5G prevede, a regime, un significativo aumento dei trasmettitori e una loro distribuzione più fitta sul territorio. Questa densificazione della rete, contrariamente a quanto accade nelle reti 2-3-4G, aumenterà la disponibilità di trasmettitori “vicini” agli utenti e consentirà di tenere basse le potenze dei trasmettitori e di stabilire una connessione senza aumentare la potenza di trasmissione dei cellulari (e dunque il calore generato).

E’ certamente vero che la trasmissione a velocità più elevate che in passato (1-10 Gbps) richiederà, inevitabilmente, una maggior potenza in ricezione per garantire la necessaria energia per bit a parità di rumore, ma questo risultato è conseguito prevalentemente attraverso il ricorso ad antenne adattative che concentrano la potenza irradiata nelle sole direzioni che contribuiscono costruttivamente al segnale ricevuto, limitando la potenza al valore necessario per raggiungere l’apparato utente.

Le frequenze millimetriche (24 GHz) assegnate per la prima volta agli operatori nella recente Asta 5G sono le meno pericolose tra tutte le frequenze finora utilizzate. Infatti, secondo le linee guida dell’ICNIRP: “Quando la frequenza dei campi elettromagnetici aumenta, l’esposizione del corpo e il riscaldamento risultante diventano più superficiali e sopra circa 6 GHz questo riscaldamento si verifica prevalentemente all’interno della pelle. Per esempio, l’86% della potenza a 6 e 300 GHz viene assorbito entro 8 e 0,2 mm dalla superficie rispettivamente (“Monte Carlo simulations of skin exposure to electromagnetic field from 10 GHz to 1 THz”. Sasaki K, et al. Phys Med Biol. 2017). Il calore è più facilmente rimosso dal corpo quando è superficiale perché è più facile che l’energia termica si trasferisca nell’ambiente attraverso convezione; questo è il motivo per cui le restrizioni di base per proteggere contro l’innalzamento della temperatura interna del corpo sono stati tradizionalmente limitate a frequenze inferiori a 10 GHz”.